pytorch 踩坑

2023-12-24 21:30:03

pytorch 踩坑

在pytorch中,如果你定义了没用的组件,同样也会影响你的模型(我也不知道从哪里影响的),看一个例子

def _make_layer(self, block, planes, blocks, stride=1, dilate=False):

norm_layer = self._norm_layer

#downsample = None

previous_dilation = self.dilation

if dilate:

self.dilation *= stride

stride = 1

# if stride != 1 or self.inplanes != planes:

# downsample = layer.SeqToANNContainer(

# nn.Conv2d(self.inplanes, planes, kernel_size=1, stride=stride),

# norm_layer(planes),

# )

layers = []

layers.append(block(self.inplanes, planes, stride

))

self.inplanes = planes

for _ in range(1, blocks):

layers.append(block(self.inplanes, planes

))

return nn.Sequential(*layers)

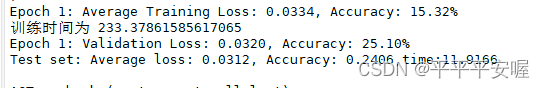

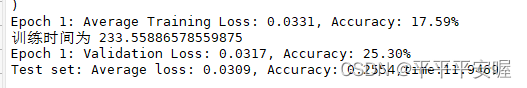

这是传统的一个_make_layer,可以看到我把其中的downsample给注释掉了,他其实是个没用的组件,我之前也没管它,我没注释前,第一个epoch

注释后

就是他其实是不参与整体模型的,但是就是会影响,我估计是影响整体模型的初始化啥的了?说不定到最后等模型收敛了结果会是差不多的。。这里我就不验证了,如果有大神看到的话可以验证一下告诉我结果,感谢!!

动机是因为,我自己写了个pytorch网络结构,然后我想写成大家都在写的这种格式,就是都封装起来,结果我发现模型结构一样,为什么两个跑的结果不一样呢,初始化和随机种子我都设置了,于是我就想去找到底哪里有问题,后面就一步步的发现了这个问题,怎么说呢,虽然最后两边的结果还是有差异,但是不多,可能还是因为一些组件的定义、组件的顺序、以及其他很小的因素都会有影响,因此在这里劝大家代码还是要写规范,这样才和别人的baseline有的比~

我一天都在调这个bug,我就在想,两个同样结构的网络,我设置了同样的随机种子和初始化,怎么会结果不同呢?

经过我一天的实验发现,你网络层定义的位置,是否创建这个网络层,都会对结果有影响,例如,如果我的downsample是通过函数传递给basicblock和我直接在函数里定义downsample,那么这样跑出来的结果还是不一样,经过两个downsample定义的方式是一样的

最后希望大家不要想我一样硬钻牛角尖,因为这样其实到头来发现不是模型的问题而是本身pytorch的问题感觉有些浪费时间,但又希望大家可以适当的钻牛角尖,毕竟一切的结果都来源于大家的坚持

文章来源:https://blog.csdn.net/abc1234564546/article/details/135186188

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!