小巧而强大:Orca 2展示出与70-130亿参数大模型同等的推理性能

引言

在人工智能的发展历程中,模型的大小和性能一直是研究者关注的焦点。微软最新推出的Orca 2模型,以其较小的体积却展现出媲美大型模型的推理能力,引领了一个全新的研究方向。

-

Huggingface模型下载:https://huggingface.co/microsoft/Orca-2-13b

-

AI快站模型免费加速下载:https://aifasthub.com/models/microsoft/Orca-2-13b

Orca 2的诞生

Orca 2是微软研究院最新推出的语言模型,继承了其前身Orca的强大推理能力。Orca 2的设计理念是利用大规模语言模型的知识来教导较小规模的模型,从而提升其推理能力。这种方法使Orca 2在训练信号的改进上取得了突破性进展。

技术革新

Orca 2在设计上采用了多种推理技巧,如逐步推理、先回忆再生成、回忆-推理-生成等,这些技巧使得Orca 2能够为每个任务确定最有效的解决策略。这种“谨慎推理”方法的核心在于不仅仅模仿更强大的模型,而是让小型模型根据任务需求灵活选择解决策略。

性能评估

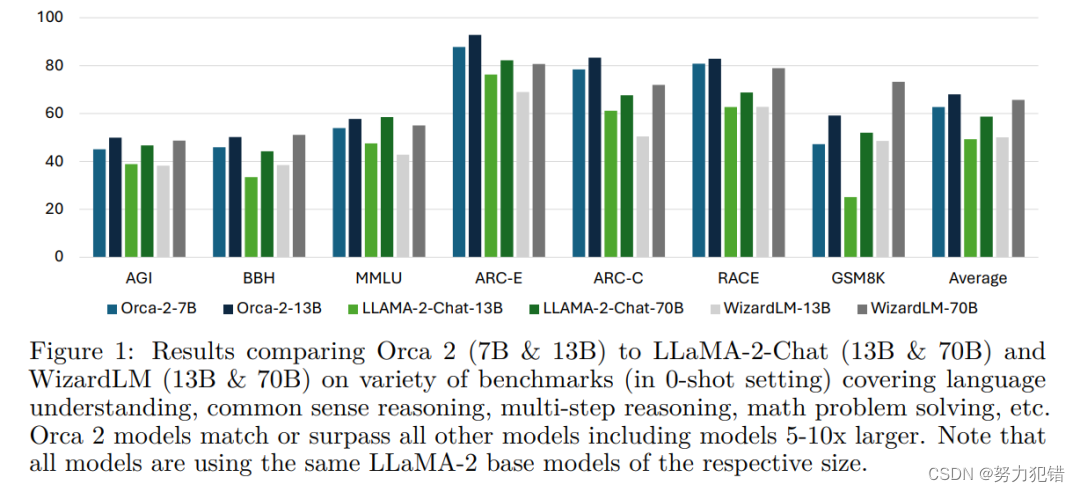

在多达15个不同基准的评估中,Orca 2表现出色。在零样本学习环境中,Orca 2的推理能力明显超越了相似规模的模型,并在某些任务中达到了与其体量5-10倍的大型模型相似或更好的性能水平。

与大型模型的比较

Orca 2有两个版本,分别是70亿和130亿参数。尽管体量小于一些大型模型,如LLaMA-2-Chat和WizardLM,Orca 2在语言理解、常识推理、多步推理等方面的表现不逊色,甚至超越了这些大型模型。

应用前景

Orca 2的开源不仅是为了鼓励在小型语言模型的开发和评估上的深入研究,也为未来AI应用的广泛领域,如对话系统、知识提取和自动文本生成等,提供了新的可能性。

结论

微软的Orca 2模型以其小巧的体量展示了巨大的潜力,它不仅打破了大模型即高性能的传统观念,也为未来的AI研究和应用开辟了新的道路。随着技术的不断进步,我们有理由相信,更多创新的小型模型将继续涌现,推动人工智能领域的持续发展。

模型下载

Huggingface模型下载

https://huggingface.co/microsoft/Orca-2-7b

https://huggingface.co/microsoft/Orca-2-13b

AI快站模型免费加速下载

https://aifasthub.com/models/microsoft/Orca-2-7b

https://aifasthub.com/models/microsoft/Orca-2-13b

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!