ChatGLM2-6B 大语言模型本地搭建

2024-01-09 14:28:07

ChatGLM模型介绍:

ChatGLM2-6B 是清华 NLP 团队于不久前发布的中英双语对话模型,它具备了强大的问答和对话功能。拥有最大32K上下文,并且在授权后可免费商用!

ChatGLM2-6B的6B代表了训练参数量为60亿,同时运用了模型量化技术,意味着用户可以在消费级的显卡上进行本地部署(INT4 量化级别下最低只需 6GB 显存)

详细介绍(官方git:https://github.com/thudm/chatglm2-6b ):

环境安装

虚拟环境创建:

查看地虚拟环境

conda env list

创建虚拟环境

conda create -n ChatGLM2-6B

激活虚拟环境

conda activate ChatGLM2-6B

下载本仓库:

git clone https://github.com/THUDM/ChatGLM2-6B

# 进入目录

cd ChatGLM2-6B

安装依赖

pip install -r requirements.txt

下载模型

从 Hugging Face Hub 下载模型需要先安装Git LF

安装Git LF

curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.deb.sh | sudo bash

sudo apt-get install git-lfs

# 验证安装成功

git lfs install

# 如果出现: Git LFS initialized. 则说明成功

git clone https://huggingface.co/THUDM/chatglm2-6b

模型下载失败

### 国内镜像地址

git clone https://hf-mirror.com/THUDM/chatglm2-6b

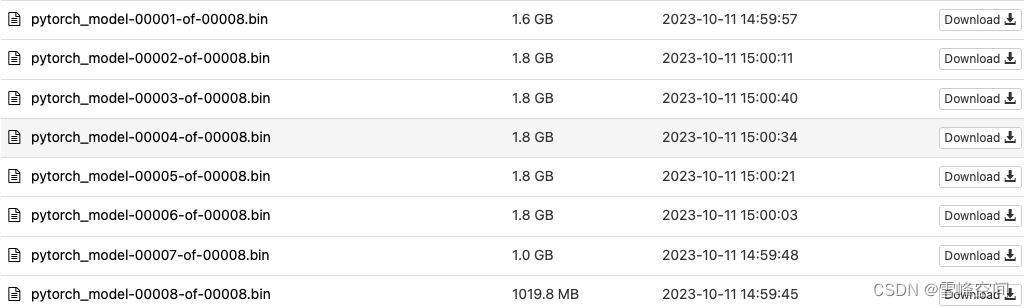

下载模型时间较长,如下载失败可尝试手动下载模型

### 手动下载模型

AI快站

https://aifasthub.com/models/THUDM

手动下载以下模模文件

wget https://aifasthub.com/models/THUDM/chatglm-6b/pytorch_model-00001-of-00008.bin

文章来源:https://blog.csdn.net/zeng_xf/article/details/135477142

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!