斯坦福机器人Mobile ALOHA的背后技术:动作分块ACT、Diffusion Policy、VINN

前言

根据上一篇文章《大模型机器人发展史:从VoxPoser、RT2到斯坦福Mobile ALOHA、Google机器人》可知,斯坦福Mobile ALOHA在其发布的论文中提到

In our experiments, we combine this co-training recipe with multiple base imitation learning approaches, including ACT [104], Diffusion Policy [18], and VINN [63]

相当于Mobile ALOHA涉及到了这三大关键技术:ACT、Diffusion Policy、VINN,故本文分三个部分一一阐述

第一部分 动作分块算法ACT

1.1?ALOHA + ACT解决现有机器人昂贵且难以做精确任务的问题

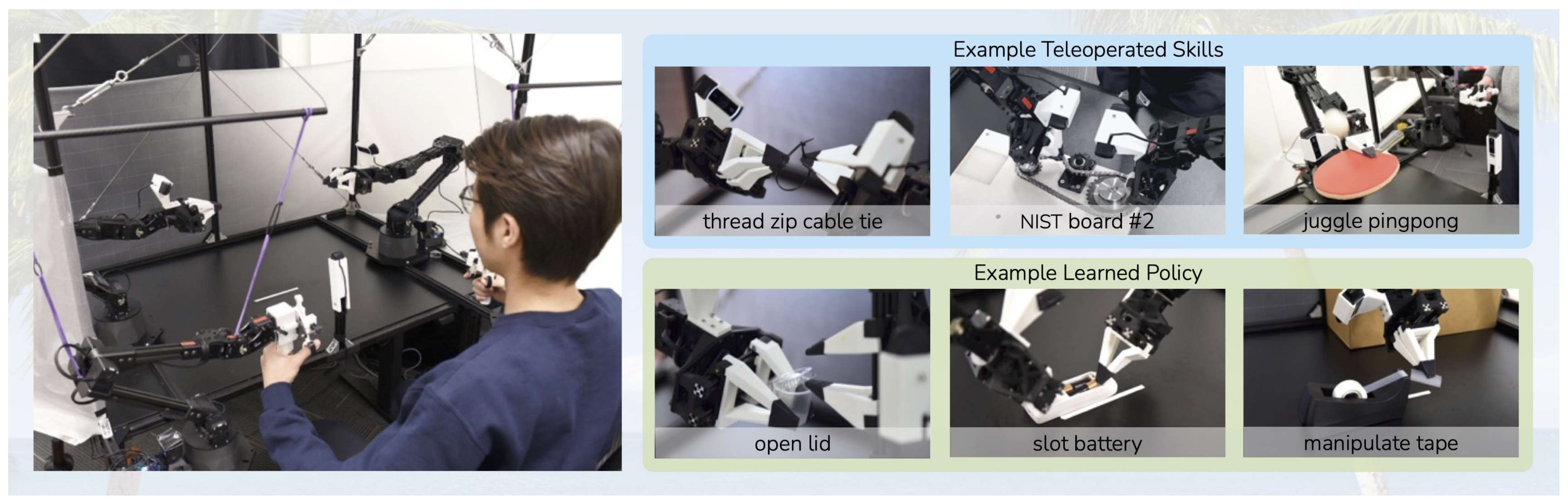

斯坦福Mobile ALOHA在被推出之前,其实在23年Q1便已有了ALOHA,所谓ALOHA,即是A Low-cost Open-source Hardware System for Bimanual Teleoperation,一个低成本的开源硬件系统,用于手动远程操作,怎么一步步来的呢?

在前两年,让机器人去完成一些抽象精细的操作任务,比如穿线扎带或开槽电池,是比较困难的

- 一方面,因为这些任务需要比较高的精准度、协调性以及闭环视觉反馈。通常情况下,执行这些任务需要使用高端机器人、精确传感器或者仔细校准设备,而且成本昂贵且难以设置。Stanford University、UC Berkeley、Meta等研究者为了让低成本和不太精确的硬件也能完成这些复杂操作,提出了一个低成本系统,可以通过定制远程操作接口收集实际演示,进行端到端的模仿学习(We present a low-cost system that performs end-to-end imitation learning directly from real demonstrations,collected with a custom teleoperation interface)

- 二方面,在高精度领域中进行模仿学习还存在挑战:策略中的错误可能会随着时间推移而累积,并且人类演示可能是非平稳的。为了解决这些挑战,该团队开发了一种动作分块算法,即Action Chunking with Transformers (ACT),它基于Transformer在动作序列上生成模型并允许机器人学习现实世界中6项困难任务(例如打开半透明调味品杯和插入电池),成功率达80-90%(这是其演示地址)

根据该团队发表的这篇论文《Learning Fine-Grained Bimanual Manipulation with Low-Cost Hardware》可知

- 他们训练了一个端到端的策略,该策略直接将来自商品网络相机的RGB图像映射到动作(we therefore train an end-to-end policy that directly maps RGB images from commodity web cameras to the actions.)。这种从像素到动作的转换方法特别适用于精细操作,因为精细操纵通常涉及具有复杂物理特质的对象,这样学习操纵策略比建模整个环境要简单得多

- 以调味品杯为例:模拟轻推杯子时的接触,以及撬开盖子时的变形,都会引起大量的物理变化。与其耗费大量的研究和具体任务的工程努力去设计一个足够精确的模型进行具体的规划,不如转化为执行上要简单的很多的策略制定,即确定轻推和打开杯子的策略或方法,因为策略可以对杯子和盖子的不同位置做出反应,而不是提前精确预测它将如何移动

Designing a model accurate enough for planning would require significant research and task specific engineering efforts. In contrast, the policy of nudging and opening the cup is much simpler, since a closed-loop policy can react to different positions of the cup and lid rather than precisely anticipating how it will move in advance

说白了,咱们不是去生成一个轻推和打开杯子的视频,不用去描绘过程,咱们只是要完成一个具体的目标(结果说话),而完成某个具体的目标有策略、有方法就行

1.1.1 模仿学习及其挑战:Action Chunking with Transformers(ACT)

系统有了,数据也好办(高质量的人类演示可以让系统学习人类的灵巧,因此,可让低成本但灵巧的遥操作系统ALOHA做数据收集),但训练一个端到端的策略(end-to-end policy)可没那么容易,因为,即使是高质量的演示,需要精度和视觉反馈的任务对模仿学习来说是一个重大挑战

- 预测动作中的小误差会引起状态的大差异,加剧模仿学习的“复合误差”问题。为了解决这个问题,我们从动作分块(action chunking)中获得灵感,这是心理学中的一个概念,描述了如何将一系列动作组合在一起作为一个块,并作为一个单元执行

Small errors in the predicted action can incur large differences in the state, exacerbating the “compounding error” problem of imitation learning [47, 64, 29]. To tackle this, we take inspiration from action chunking, a concept in psychology that describes how sequences of actions are grouped together as a chunk, and executed as one unit [35]. - 在他们的案例中,策略预测了接下来k个时间步的目标关节位置,而不仅仅是一次一步。这通过k折减少了任务的有效视界,减轻了复合误差

In our case, the policy predicts the target joint positions for the next k timesteps, rather than just one step at a time. This reduces the effective horizon of the task by k-fold, mitigating compounding errors.

预测动作序列也有助于解决时间相关的干扰因素,例如难以用马尔可夫单步策略建模的演示中的停顿

Predicting action sequences also helps tackle temporally correlated confounders [61], such as pauses in demonstrations that are hard to model with Markovian single-step policies. - 为了进一步提高策略的平滑性,本文提出了时间集成,更频繁地查询策略,并在重叠的动作块上进行平均。我们使用Transformers[65](一种为序列建模而设计的架构)实现动作分块策略,并将其训练为条件VAE (CVAE),以捕获人类数据中的可变性。他们将该方法命名为Action Chunking with Transformers(ACT),并发现它在一系列模拟和现实世界的精细操作任务上显著优于以前的模仿学习算法

To further improve the smoothness of the policy, we propose temporal ensembling, which queries the policy more frequently and averages across the overlapping action chunks. We implement action chunking policy with Transformers [65], an architecture designed for sequence modeling, and train it as a conditional VAE (CVAE) [55, 33] to capture the variability in human data. We name our method Action Chunking with Transformers (ACT), and find that it significantly outperforms previous imitation learning algorithms on a range of simulated and real-world fine manipulation tasks.

1.1.2 行为克隆(Behavioral cloning, BC)中为何要引入ACT

模仿学习可以让机器人直接向专家学习,而行为克隆(Behavioral cloning, BC)是最简单的模仿学习算法之一,将模仿作为从观察到行动的监督学习

- BC的一个主要缺点是复合误差,以前时间步长的误差累积并导致机器人偏离其训练分布,导致难以恢复状态[47,64]。这个问题在精细操作设置[29]中尤为突出。减轻复合错误的一种方法是允许额外的政策上的交互和专家修正,如DAgger[47]及其变体[30,40,24]

- 然而,对于遥操作界面[29],专家注释可能是耗时且不自然的。人们也可以在演示采集时注入噪声以获得具有纠正行为[36]的数据集,但对于精细操作而言,这种噪声注入会直接导致任务失败,降低遥操作系统的灵巧度。为了规避这些问题,之前的工作以离线的方式生成合成校正数据[16,29,70]。虽然它们仅限于可获得低维状态的设置,或特定类型的任务,如抓取。由于这些限制,我们需要从不同的角度来解决复合误差问题,好与高维视觉观察兼容

- 因此建议通过动作分块(action chunking)来减少任务的有效视界,即预测一个动作序列而不是单个动作,然后跨重叠的动作块进行集成,以产生既准确又平滑的轨迹

1.2?ALOHA:低成本的开源硬件系统,用于手动远程操作

我们已经知道市面上已有类似达芬奇外科手术机器人或ABB YuMi这样的机器人,但成本一般比较昂贵。他们团队则转向低成本硬件(很类似七月在一系列大模型应用上的探索,侧重小团队 低成本 大效果),例如每个成本约为5k美元的手臂,并寻求使它们能够执行高精度、闭环任务。我们的遥操作设置最类似于Kim等人的[32],也使用了人类遥控者和跟随者机器人之间的关节空间映射。与之前的这个系统不同,我们没有使用特殊的编码器、传感器或加工部件。他们只使用现成的机器人和少量3D打印部件来构建他们的系统,让非专业人士在不到2小时内组装好它,其具备以下五个特点

- 低成本:整个系统应该在大多数机器人实验室的预算之内,可与单个工业手臂相媲美

- 通用性:它可以应用于广泛的与现实物体的精细操作任务

- 人性化:系统应该直观、可靠、易于使用

- 可修复:当设置不可避免地出现故障时,研究人员可以轻松修复设置

- 易于搭建:研究人员可以快速组装,材料来源容易

在选择要使用的机器人时

- 原则1、4和5使建立了一个双手平行颚夹持器设置与两个ViperX 6-DoF机器人手臂[1,66]

- 出于价格和维护方面的考虑,我们不使用灵巧手。使用的ViperX臂具有750克和1.5米跨度的工作有效载荷,精度为5-8毫米

- 该机器人模块化,维修简单:在电机出现故障的情况下,低成本的Dynamixel电机可以轻松更换。这种机器人可以以5600美元左右的价格购买到现货。然而,OEM的手指不够通用,无法处理精细的操作任务。因此,我们设计了自己的3D打印“透明”手指,并将其贴合在夹持胶带上

第二部分?Diffusion Policy

// 待更

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!