论文阅读-Null-text Inversion for Editing Real Images using Guided Diffusion Models

2023-12-13 04:04:18

一、论文信息

作者团队:

论文链接:https://arxiv.org/pdf/2211.09794.pdf

代码链接:https://github.com/google/prompt-to-prompt

二、Conditional Diffusion(classifier-free guidance)

Classifier-free guidance方法训练:

对于有条件的训练集(如图文对数据集),以某个概率p将其中的某些条件置为空,然后进行训练。

实际生成:![]()

三、DDIM Inversion

-

DDPM生成图像的反向去噪过程(由Xt去预测Xt-1):

当随机噪声的系数=0,此时变为确定性采样过程,一旦初始的噪声XT确定了,样本的生成也就变为确定过程。

-

DDIM inversion:

DDIM的逆过程,即对于原图像进行加噪,最终得到一张噪声图。

将该噪声图作为采样起点进行去噪,最终又会生成原图像(即实现对原图像的重建过程)。这一整个过程常被用于图像编辑等任务。

四、Null-text Inversion

-

动机

利用DDIM Inversion做图像重建或图像编辑任务时,直接做有条件的DDIM重建会导致误差累积,从而导致重建结果逐渐偏离原图像;

现有的图像编辑方法大多需要对模型进行微调,或对模型权重、内部结构等进行优化,操作起来比较复杂。

-

本文方法:null-text inversion

首先对输入图像提取caption,然后在每个采样时间步t,都利用以下损失函数对null-text embedding进行优化

约束损失:

最终得到每个采样时间节点t所对应的优化后的null-text embedding,并实现对图像的重建。

利用DDIM Inversion得到的ZT和优化后的null-text embedding序列,可以实现有条件的图像编辑。

-

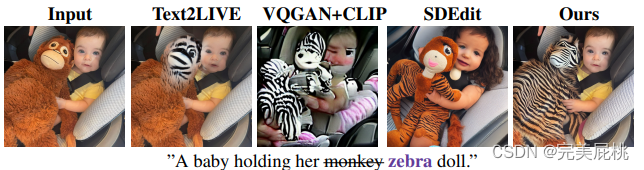

实验结果

文章来源:https://blog.csdn.net/qq_43687860/article/details/134805164

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!