Saliency Prediction in the Deep LearningEra: Successes and Limitations

摘要:

近年来,由于深度学习和大规模注释数据的进步,视觉显著性模型在性能上有了很大的飞跃。然而,尽管付出了巨大的努力并取得了巨大的突破,但模型在达到人类水平的准确性方面仍然存在差距。在这项工作中,我探索了该领域的景观,强调了新的深度显著性模型、基准和数据集。大量的图像和视频显著性模型在两个图像基准和两个大规模视频数据集上进行了审查和比较。此外,我确定了导致模型和人类之间差距的因素,并讨论了需要解决的剩余问题,以构建下一代更强大的显著性模型。一些具体的问题包括:当前的模型在哪些方面失败了,如何补救它们,可以从注意力的认知研究中学到什么,明确的显著性判断如何与固定相关联,如何进行公平的模型比较,以及显著性模型的新兴应用是什么。

1.介绍

视觉注意力使人类能够快速分析复杂的场景,并将有限的感知和认知资源投入到最相关的感官数据子集中。它作为一个可移动的信息处理瓶颈,只允许在限定区域内的物体达到更高的处理和视觉感知水平[1]。

从广义上讲,关于注意力模型的文献可以分为两类:任务不可知方法(即寻找突出信息,即自下而上(BU)显著性[1],[2],[3],[4])和任务特定方法(即寻找与正在进行的行为,任务或目标相关的信息[5],[6])。自下而上的显著性是视觉引导中研究最广泛的方面。Itti等人[3]在1998年建立的模型引发了计算机视觉社区对视觉显著性的大量兴趣。从那以后,有很多后续作品使用了更好的手工制作的功能和学习方法。

这些作品定期出现在该领域的顶级场地。在短暂的抑郁和表现饱和后(?2010 - 2014),并受到三个因素的驱动:a)行为研究发现吸引凝视的线索(例如,凝视方向),b)大规模众包数据(例如,鼠标运动)表明什么是显著的,以及c)深度神经网络(dnn)的复兴,一系列深度显著性模型已经出现。这些模型在公认的显著性基准上比经典模型有了巨大的改进,并且表现接近人类观察者间(人类IO)模型(基于其他人的注视),因此在某些情况下,几乎不可能将模型预测与实际的注视图区分开来(见图1)。

然而,新的基于神经网络的模型仍然存在一些基本问题,导致它们的表现不如人类[7]。因此,退后一步,研究显著性模型目前的能力,以及可以改进的地方是至关重要的。此外,需要系统的努力来解决新出现的挑战,重新评估当前的成功,并探索模型是否确实在性能上不断变得更好或饱和。?

为此,我提出以下问题:显著性模型预测了什么,它们在哪里失败,为什么失败,如何以更细粒度的方式评估模型,哪些是吸引注意力但未被模型考虑的剩余线索,显式显著性测量在多大程度上与眼球运动一致,显著性模型的泛化程度如何,哪些新类型的数据可用于揭示模型的优点和缺点,哪些测量最能代表模型的性能,鉴于深度学习的最新进展,哪些新应用成为可能,以及显著性如何从其他领域受益或做出贡献。

在深入研究这些问题之前,我首先回顾了显著性领域的概况,并使用多个分数对图像和视频数据集上的大量静态和动态显著性模型进行了定量比较。结果是根据我们自己最近的会议出版物和在线基准以及同事在该领域的出版物编制的。?

这项工作更新了我在2013年对该领域的最后一次回顾[4],[8],并专注于深度视觉显著性模型。从那时起,在建立模型,收集数据,理解模型的局限性,以及评价措施的设计。

读者可参考[7]、[10]、[11]、[12]、[13]、[14]、[15]进行评论。

1.1 意义及应用

视觉显著性模型的意义有两个方面。首先,他们提出了可测试的预测,可用于在行为和神经水平上理解人类的注意力机制。事实上,大量的认知研究已经利用显著性模型进行基于模型的假设检验。其次,预测人们在图像和视频中的位置在多个领域(例如,计算机视觉、机器人、神经科学、医学、辅助系统、医疗保健、人机交互和国防)的各种应用中都很有用。一些示例应用包括注视感知压缩和摘要、活动识别、对象分割、识别和检测、图像字幕、问题回答、广告、新手培训、患者诊断和监视。

1.2 范围

这项工作的主要焦点是在自由观看自然场景时对视觉显著性和注意力的建模,特别是最近的进展。一些相关的研究领域,包括自上而下的注意力和自我中心凝视预测,突出目标检测和分割,共同显著性检测,以及深度学习可视化的显著性。

2 SALIENCY IN THE DEEP LEARNING ERA

2.1 benchmarks

基准测试对计算机视觉的进步起到了重要作用。在显著性领域,它们在过去几年里引发了很多兴趣,激发了很多有趣的想法。最具影响力的两个基于图像的机构包括MIT和SALICON。

麻省理工学院。麻省理工学院的基准是目前评估和比较基于图像的显著性模型的黄金标准。它支持8种评估方法进行比较,并报告两个眼动数据集(1)MIT300和2)CAT2000的结果。截至2018年10月,我们已经在MIT300数据集上评估了85个模型,其中26个是基于神经网络的模型(?占所有提交作品的30%)。CAT2000数据集迄今评估了30个模型(9个是基于神经网络的)。此外,还在两个数据集上计算了5条基线

SALICON。也被称为LSUN显著性挑战(与LSUN挑战一起,包括iSUN数据集[19]),它是相对较新的,主要基于SALICON数据集。它提供超过7分的结果,并使用与麻省理工学院基准相同的评估工具。

这两个基准是相互补充的。前者根据实际固定值来评估模型,但受到小尺度数据的影响。麻省理工学院的基准是基于AUC-Judd对模型进行排名,而SALICON的排名是基于sAUC。此外,与SALICON不同,MIT benchmark保持着最新的排行榜。

2.2 Datasets

传统上,通过将显着性模型的输出与人类观看复杂图像或视频刺激时的眼动进行比较来验证显着性模型(例如[20],[21])。

新的数据库通过以下两种趋势出现:1)增加图像的数量,2)通过提供上下文注释(例如,图像类别,区域属性等)引入新的显著性度量。为了标注大规模数据,研究人员采用了众包方案,如使用网络摄像头[19]或鼠标运动[22][23]进行凝视跟踪,以替代基于实验室的眼动仪(图2)。深度监督显著性模型严重依赖于这些足够大且标记良好的数据集。

在这里,我回顾了一些最新和最有影响力的图像和视频数据集。关于这些数据集的利弊的讨论将推迟到第4节。

图像数据集。以下是用于训练和测试模型的三个最流行的图像数据集

? MIT300:该数据集是来自Flickr知识共享和个人收藏的300幅自然图像的集合[25]。它包含了39个观察者的眼球运动数据,这是一个相当可靠的基础事实,可以用来测试模型。对于显著性模型来说,这是一个具有挑战性的数据集,因为图像是高度变化和自然的。所有图像的固定图被拿出,并被麻省理工学院显著性基准用于评估模型。

? CAT2000:发布于2015年,这是一个相对较大的数据集,由2000张训练图像和2000张测试图像组成,涵盖漫画、艺术、卫星、低分辨率图像、室内、室外、线条图等20个类别[25]。本数据集中的图像来自搜索引擎和计算机视觉数据集。训练集每个类别包含100张图像,并有来自18个观察者的固定注释。用于评估的测试测试包含24个观察者的注视。MIT300和CAT2000数据集都是使用EyeLink1000眼动仪收集的。

? SALICON:由Jiang等人[22]引入,是目前最大的众包显著性数据集。该数据集中的图像来自Microsoft COCO数据集,并包含MS COCO的像素级语义注释。SALICON数据集包含10000张训练图像,5000张验证图像和5000张测试图像。使用Amazon Mechanical Turk (AMT)通过一种称为鼠标偶然显著性注释的心理物理范式收集鼠标运动(图2)。尽管眼球运动和鼠标运动之间存在微小差异,但该数据集引入了一种可接受且可扩展的方法,用于收集进一步的显著性建模数据。目前,许多深度显著性模型首先在SALICON数据集上进行训练,然后在MIT1000[26]或CAT2000数据集上进行微调,以预测注视。

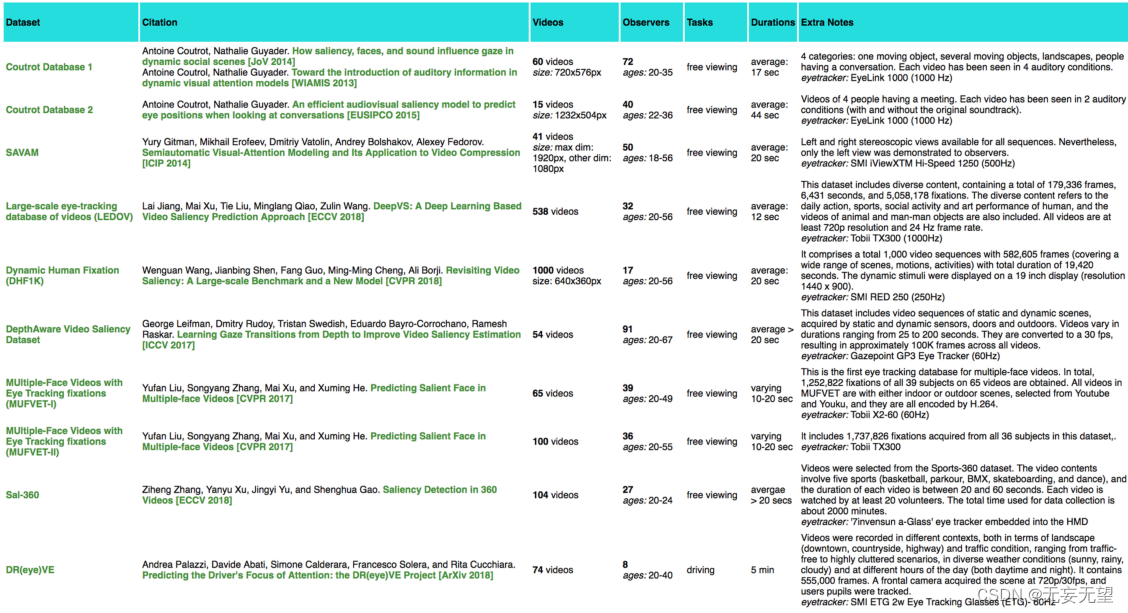

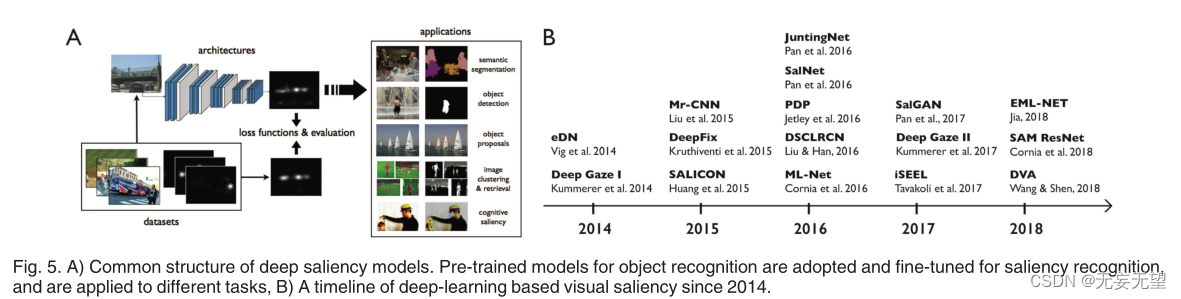

图3显示了最近的图像数据集列表。已经收集了一些数据集来研究特定刺激(例如,查看信息图表[27],人群[28],网页[29],[30],情感内容[31],[32])或某些任务(例如,驾驶[33],[34])的视觉注意力。

视频数据集。DIEM[35]、HOLLYWOOD-2[36]和UCF-Sports[36]是视频显著性研究中被广泛使用的三个数据集。DIEM包含84个不同类别的视频(如广告、纪录片、体育赛事和电影预告片);持续时间从20秒到超过200秒不等)和来自50名受试者的自由观看注视数据。HOLLYWOOD-2是目前最大的动态眼动追踪数据集,包含823个训练序列和884个验证序列,包含16个被试的注视数据。这个数据集中的视频是来自69部好莱坞电影的短视频序列,包含12种不同的人类动作类,从接电话、吃饭、开车、跑步等。UCF-Sports数据集包含9个运动动作类的150个视频,如跳水、摇摆、步行等,平均时长为6.39秒。它由16名受试者观看。

最近,两名新人加入了这个联盟

?DHF1K:在[37]中,我们引入了一个数据集,该数据集由17个受试者观看的总共1000个视频序列组成。视频包含582,605帧,涵盖了广泛的场景、动作和活动。它的总持续时间为19,420秒。动态刺激显示在19英寸的显示器上(分辨率为1440 ?900 px)。

? LEDOV:由Jiang等人[38]引入,该数据集包括日常行为、体育、社会活动和艺术表演等多种内容。它包含179,336帧,5,058,178个固定点和6,431秒。所有538个视频至少具有720px分辨率和24hz帧率。

图4显示了最近的视频显著性数据集的列表。一些数据集是为特殊目的而收集的,如研究多模态注意力(例如,Coutrot 1和2[39]),探索多面视频的注意力(MUFVET I和II[40]),或建模3D显着性(例如,Sal-360?[41],[42])。?

2.3 Evaluation Measures

已经提出了几种评估显著性模型的方法。一般来说,它们分为两类:

a)基于分布(即比较平滑的预测图和固定图)和

b)基于位置(即计算固定位置的一些统计数据)。

Pearson’s Correlation Coefficient (CC)、KullbackLeibler divergence (KL)、Earth Mover’s Distance (EMD)[43]、Similarity or histogram intersection (SIM)[43]属于第一类。归一化扫描路径显著性(Normalized Scanpath Saliency, NSS)[44]、ROC曲线下面积(Area under ROC Curve, AUC)及其变体AUC- judd[26]、AUC- borji[25]、Shuffled AUC (sAUC)[45]属于第二类。最近,信息增益(Information Gain, IG)也被加入到这个集合中[46]。它测量的是显著性图在固定位置相对于中心先验基线的平均信息增益[11]。这些分数所产生的排名往往彼此不匹配。

尽管如此,人们普遍认为,这些措施是相互补充的,并评估显著性地图的不同方面。此外,人们认为,一个好的模型应该在各种度量中表现良好。有关如何计算这些指标的详细说明,请参阅[11]、[25]。我将在稍后的第4节中回到模型评估和评分。

2.4 Classical (Non-Deep) Bottom-Up Saliency Models

自下而上注意力的计算建模可以追溯到1980年Treisman和Gelade的开创性作品[2],1985年Koch和Ullman的计算架构[48],以及1998年Itti等人的自下而上模型[3]。

在这些工作的基础上,提出了几个显著性模型。根据我们2013年的研究[4],它们分为不同的类别(例如,贝叶斯,基于学习的,光谱的,认知的)。早期的模型主要依赖于在尺度空间中提取简单的特征映射,如强度、颜色、方向等,并在进行中心环绕和归一化操作后进行组合。随后的模型纳入了中高级特征(例如,面部和文本[49],凝视方向[50]),以更好地预测凝视。

在这有限的篇幅内,对所有经典显著性模型进行彻底的检查当然是不可行的。相反,我列出了一些非常有影响力的静态和动态显著性模型,如:关注信息最大化(AIM)[21]、基于图的视觉显著性(GBVS)[51]、使用自然统计的显著性(SUN)[45]、光谱残差显著性(SR)[52]、自适应美白显著性(AWS)[53]、基于布尔图的显著性(BMS)[54]和Judd模型[26]。一些经典的视频显著性模型包括:AWS-D[55]、OBDL[56]、Xu等[57]、PQFT[58]和Rudoy等[59]。

2.5 Deep Saliency Models

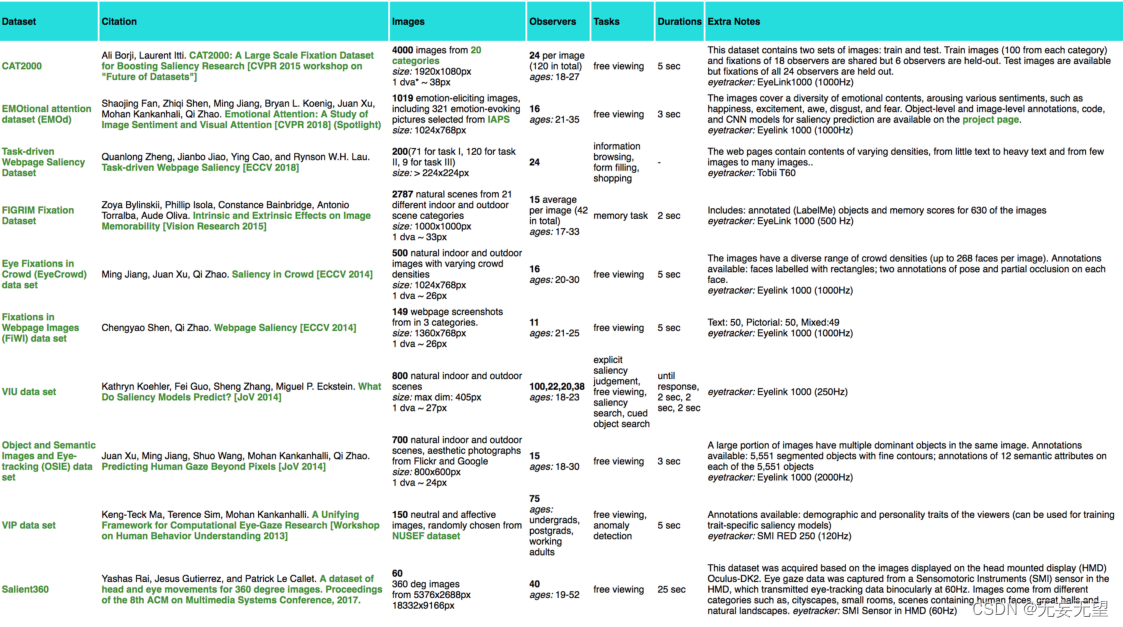

卷积神经网络(CNN)[60]在大规模对象识别语料库[61]上的成功,带来了新一波显著性模型,其表现明显优于基于手工特征的传统显著性模型。研究人员利用现有的cnn进行场景识别训练,并将其重新用于预测显著性。通常还会引入一些架构上的新奇之处。这些模型以端到端的方式进行训练,有效地将显著性表述为回归问题(见图a)。

为弥补大规模注视数据集的不足,深度显著性模型在大型图像数据集上进行预训练,然后在小规模眼动或点击数据集上进行微调。这个过程允许模型重用cnn中已经学习到的语义视觉知识,并成功地将其转移到显著性任务中。接下来,我将回顾一些具有里程碑意义的深度空间和时空显著性模型?

2.5.1 Static Saliency Models

图B给出了深度显著性模型自2014年建立以来的时间轴。它构成了这里讨论模型的基础

eDN。Vig等人[62]提出的eDN(深度网络集成)是利用cnn预测图像显著性的第一次尝试。首先,它使用受生物学启发的分层特征生成大量丰富参数化的1到3层网络。然后,利用超参数优化的方法搜索具有显著性预测的独立模型,并通过训练线性支持向量机将其合并为单个模型

DeepGaze I & II。K€summerer等人[63]提出使用相对较深的CNN(预训练的AlexNet[64])进行显著性预测(5层,而eDN的1-3层)。卷积层的输出被用来创建和训练一个线性模型来计算图像显著性。最近,他们引入了基于DeepGaze i的DeepGaze II模型[65],进一步探讨了低水平和高水平特征对注视预测的独特贡献,并在MIT300数据集上获得了AUC-Judd分数的最佳性能。

Mr-CNN。Liu等[66]提出了多分辨率CNN (Mr-CNN)模型,其中三个不同的CNN,每个CNN在不同的尺度上训练,后面是两个完全连接的层。他们对以固定和非固定位置为中心的图像块进行了微调。

SALICON。为了帮助弥合显著性建模中的语义差距(模型无法预测由强语义内容驱动的凝视),Huang等人[16]提出了一种深度CNN(基于AlexNet、VGG-16和GoogLeNet),该CNN结合了来自两个预训练CNN的信息,每个CNN都在不同的图像尺度上(精细和粗糙)。然后将两个cnn连接起来生成最终的地图。

DeepFix。Kruthiventi等人[67]建立的该模型是首次将全卷积神经网络(FCNN)应用于显著性预测。它使用了5个卷积块,权重从VGG-16初始化,然后是两个新颖的基于位置的卷积(LBC)层,以捕获多个尺度的语义。它还结合了高斯先验来进一步提高学习权值。

ML-Net。该模型[68]没有在最终的CNN层使用特征,而是将从VGG网络的不同层次提取的特征图结合起来计算显著性。为了预先对中心建模,它端到端学习一组高斯参数,而不是使用固定的高斯参数或将高斯参数馈送到卷积层。此外,它还受益于一个新的损失函数,以满足三个目标:1)更好地度量与地面真值的相似度,2)使预测映射不变到最大值,3)赋予具有更高固定概率的位置更高的权重。

JuntingNet和SalNet。Pan等[69]提出了一个浅层CNN (JuntingNet)和一个深层CNN (SalNet)用于显著性预测。前者受到AlexNet的启发,使用三个卷积层和两个完全连接的层,这些层都是随机初始化的(即从头开始训练)。后者包含八个卷积层,前三个层是从VGG网络初始化的。

PDP。由Jetley等人[70]提出的概率分布预测(Probability Distribution Prediction, PDP)将显著性表述为广义伯努利分布,并训练模型来学习该分布。它包含一个完全端到端训练的深度神经网络,使用一种新的损失函数,将经典的softmax损失与计算不同概率分布之间距离的函数配对。根据Jetley等人的结果,对于显著性预测任务,新的损失函数比传统的损失函数如欧几里得损失和Huber损失更有效。

DSCLRCN。DSCLRCN模型(Deep Spatial Contextual Long-term Recurrent Convolutional Neural network)由Liu和Han[71]于2016年提出。它首先使用CNN学习小图像区域的局部显著性。然后,它使用深空间长短期模型(LSTM)对图像进行水平和垂直扫描,以捕获全局上下文。这两个操作允许DSCLRCN同时有效地结合局部和全局上下文来推断图像的显著性。

SalGAN。Pan等[72]利用生成对抗网络(Generative Adversarial Networks, GANs)[73]构建了SalGAN模型。它由两个模块组成,一个产生器和一个鉴别器。生成器通过在现有显著性图上使用二元交叉熵损失的反向传播来学习,然后将其传递给鉴别器,鉴别器被训练以识别所提供的显著性图是由生成器合成的,还是从实际的固定点构建的。

iSEEL。在[74]中,我们提出了一种基于图像间相似性和极限学习机(ELM)集成的显著性模型[75]。首先,检索与给定图像相似的一组图像。显著性预测器使用ELM从该集合中的每个图像中提取图像,从而得到一个集合。最后,对集合成员的显著性映射进行平均,以构造最终的映射。

EML-Net。可扩展多层网络(EML-NET)的主要思想是,FCNN中的编码器和解码器可以分别进行可扩展性训练[76]。此外,编码器可以包含多个CNN模型来提取特征,这些模型可以具有不同的架构或在不同的数据集上进行预训练。在将图像输入到解码器后,计算并组合来自两个不同cnn的滤波器映射以形成最终的显著性映射。

DVA。Wang等人[77]提出了深度视觉注意(DVA)模型,在该模型中,编码器-解码器架构在多个尺度上进行训练,以预测逐像素的显著性。编码器部分是一堆卷积层。通过从编码器网络的三个不同阶段获取输入,形成三个解码器,最后融合以产生显著性图。

SAM Net。Cornia等[78]提出的显著性关注模型(Saliency attention Models, SAM-ResNet & SAM-VGG)将全卷积网络与递归卷积网络结合在一起,赋予其空间关注机制。

Focus.Bruce等人[79]提出了一个被认为是完全卷积显著性(焦点)的模型,该模型既适用于凝视,也适用于显著物体预测。它集成了来自大规模CNN模型的预训练层,然后在PASCAL-Context数据集上进行微调[80]。

注意力。Gorji和Clark[81]提出通过共享注意力来增强标准的深度显著性模型。他们的模型包含两个路径:一个是学习场景参与者注视位置的注意力推送路径,另一个是显著性路径。然后是一个浅增广显著性CNN,它将它们组合在一起并生成增广显著性。他们初始化并训练了注意力推送CNN,通过使用大规模的注视跟踪数据集最小化在2D网格上跟踪演员注视位置的分类误差。然后,注意力推送CNN与增强显著性CNN一起进行微调,使用眼动追踪数据集,用场景演员的头部和凝视位置进行注释,以最小化增强显著性和地面真实注视之间的欧几里得距离。该模型表现良好,但存在评估过程中需要人为标注角色头部位置的局限性。原因是,在许多图像中,演员都是看向侧面或不看镜头,这使得人脸检测成为一项非常具有挑战性的任务,即使对性能最好的人脸检测器来说也是如此。

其他一些深层静态显著性模型包括[82]、[83]、[84]、[85]、[86]。我在这一节的重点是预测固定密度图的模型。深度学习也被用于构建扫描路径预测模型(例如,[87],[88])。

2.5.2 Dynamic Saliency Models

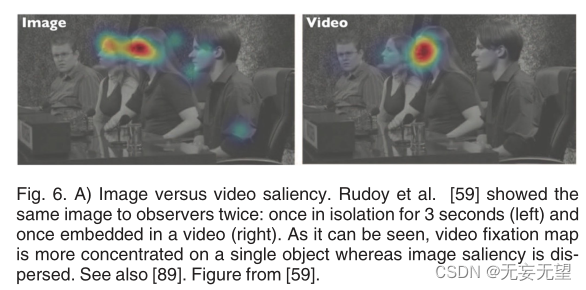

观察者观看视频和图像的方式不同有两个原因(图A)。首先,观察者观看每个视频帧的时间要少得多(大约1/30秒),而观看静止图像的时间为3到5秒。其次,动态是静止图像中缺少的关键组成部分,比视频更能吸引人们的注意力。再加上对高计算和内存需求的需求,使得视频显着性预测比图像显着性预测更具挑战性。尽管存在这些障碍,但在过去几年中,部分受其应用(例如,视频摘要,图像和视频字幕)的推动,人们对视频显著性的兴趣越来越大。

通常,视频显著性模型将自下而上的特征提取与可通过光流或特征跟踪执行的自组织运动估计配对。相比之下,深度视频显著性模型端到端学习整个过程。在这些工作中,动态特性以两种方式建模:a)向cnn添加时间信息,或2)使用lstm开发动态结构。下面将介绍这两种类型的模型。

Two-Stream Network.。作为最早的尝试之一,Bak等人[90]应用了两流(各5层)CNN架构进行视频显著性预测。RGB帧和运动地图被馈送到两个流。?

Chaabouni et al.Chaabouni等人[91]采用迁移学习来调整先前训练好的深度网络,用于自然视频的显著性预测。他们在RGB彩色平面和每个视频帧的残余运动上训练了一个5层CNN。然而,他们的模型只使用了两个连续帧的非常短期的时间关系。

Bazzani等人在[92]中提出了一种循环混合密度网络用于显著性预测。将16帧的输入片段馈送到3D CNN,其输出成为LSTM的输入。最后,线性层将LSTM表示投影到描述显著性映射的高斯混合模型。类似地,Liu等人[40]应用lstm来预测视频显著性图,依赖于注意力部署的短期和长期记忆。

OM-CNN。Jiang等人[93]提出的Object-toMotion CNN模型包括两个端到端训练的对象和运动子网。利用物体和物体运动信息来预测视频的帧内显著性。帧间显著性通过结构敏感的ConvLSTM体系结构计算。

Leifman等人在[94]中,将RGB色彩平面、密集光流图、深度图和之前的显著性图馈送到7层编码器-解码器结构中,以预测在2D屏幕上观看RGBD视频的观察者的注视。

Gorji & Clark。正如他们之前的工作[95]一样,他们在这里使用多流ConvLSTM来增强具有动态注意力推送(共享注意力)的最先进的静态显著性模型。他们的网络包含一个显著性通路和三个推通路,包括凝视跟随、快速场景变化和注意力反弹。多路径结构之后是一个CNN,它学习组合通过最小化增强显著性和观看者对视频的注视之间的相对熵来实现cnnlstm的互补和时变输出。

ACLNet。在[37]中,我们提出了细心的CNN-LSTM网络,该网络通过监督注意机制增强CNN-LSTM,以实现快速的端到端显著性学习。注意机制明确编码静态显著性信息,允许LSTM专注于学习跨连续框架的更灵活的时间显著性表示。这样的设计充分利用了现有的大规模静态固定数据集,避免了过拟合,显著提高了训练效率。

SG-FCN。Sun等人[96]提出了一种鲁棒的深度模型,该模型利用记忆和运动信息来捕捉连续帧之间的突出点。考虑到相邻两帧之间的变化被限制在一定范围内,因此相应的注视点应该保持相关,利用记忆信息来增强模型的泛化。

2.5.3 Common Design Patterns in Deep Saliency Models

尽管表面上存在差异,但模型共享一些规范结构。普通cnn自动和隐式地捕获上下文。为了学习更好的表示,一些模型(例如SALICON)明确地在几个尺度上处理图像。由于连续的卷积和池化层会丢失一些图像信息,一些模型利用跳过连接来保留丢失的信息。虽然跳跃连接在显著目标检测中非常流行,但尚未充分利用跳跃连接进行注视预测。

在cnn中加入上下文的更复杂的方法,例如使用预训练的场景分类模型或使用rnn水平或垂直扫描图像,已被证明对显著性预测非常有影响(例如,DSCLRCN)。这样一来,全局和局部环境都自然地被考虑在内,这对于经典模型来说是很困难的。rnn的加入也有助于改进预测图的细节。

上述技术在语义分割等逐像素标记任务中至关重要。另一个重要因素是损失函数的选择。虽然通常一个分数是优化的(例如,NSS, CC, KL),但一些研究(例如,[37])表明,聚合多个分数是有帮助的。在视频固定预测领域,流行的架构包括多流(使用RGB、运动等)、多模态(深度、光流等)和3D cnn(一些增强了rnn[92])。

在图像和视频领域,与显著的目标检测模型相比,固定预测模型中的结构多样性似乎更少。一些架构尚未进行固定预测测试(例如,多任务、侧融合网络和分支网络[97])。此外,用于动作识别和目标跟踪的深度架构尚未被用于视频固定预测。代替人工设计网络,一个有前途的方向是求助于自动机器学习(AutoML)工具来搜索可能的架构空间。

2.6 Deep versus Classical Saliency Models

考虑一个CNN,它有一个单独的卷积层,后面跟着一个被训练用来预测注视的完全连接层。该模型推广了经典的Itti模型,以及在其基础上建立的学习组合特征映射的模型(例如,[98],[99],[100])。CNN中学习到的特征将对应于方向、颜色、强度等,这些特征可以通过全连接层(或1 ?1个卷积(在全卷积网络中)。为了处理显著性计算的尺度依赖性,经典模型通常采用多个图像分辨率。除了这种技术(如SALICON),深度显著性模型连接来自几个卷积层的映射(如ML-Net),或者从不同的编码器层向解码器提供输入(例如,使用跳过连接)以保留精细的细节。

尽管有上述相似之处,经典模型(例如,Itti模型)相对于今天的深度体系结构最明显的缺点是缺乏提取更高层次特征、对象或对象部分的能力。一些经典模型通过显式地结合对象检测器(如人脸检测器或文本检测器)来弥补这一缺陷。cnn的层次深层结构(例如,ResNet中的152层[101])允许捕获自动吸引眼球的复杂线索。这可能是两种型号之间性能差距较大的主要原因。

然而,在实践中,研究表明,在某些情况下,经典显著性模型胜过深度模型,这表明当前的深度模型仍然无法完全解释低水平显著性(图13)。此外,深度模型无法捕获一些高层次的注意力线索(例如,凝视方向)。我将在第4节中进一步讨论这些问题。

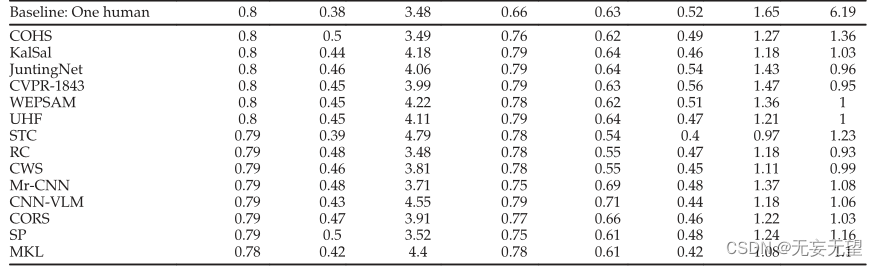

3 STATE OF THE ART PERFORMANCE

本文在两个图像基准(MIT[25]和SALICON[16])以及两个视频数据集(DHF1K[38]和LEDOV[38])上对静态和动态显著性模型进行了定量比较。对于MIT和DHF1K基准,我从我们的在线基准门户网站编译结果,而对于其他两个,我求助于该领域其他研究人员的出版物。

3.1 Performance on Images

3.1.1 The MIT Benchmark

该基准具有最全面的一套传统和深度显著性模型。计算8分。除了模型之外,还考虑了以下5条基线。

1)Infinite humans::无限观察者的注视图如何预测来自另一组无限观察者的注视,作为极限计算?考虑两组n个观察者。第一组的注视被用来预测第二组的注视。通过改变n并对这些点拟合幂函数,计算出经验极限。详情请参见[11]。

2)One human:一个观察者的注视图(作为显著性图)对另一个观察者的注视预测有多好?1观察人士?这依次为每个观察者计算,并对所有n个观察者取平均值,剩下的人,这样就得到了一系列的预测分数。

3)Center::在假设图像的中心最突出的情况下,拉伸对称高斯以拟合给定图像的宽高比[102]。

4)Permutation control:对于每张图像,不是随机采样注视点,而是选择随机采样图像中的注视点作为显著性图。每个图像重复此过程5次,并计算平均性能。该方法允许捕获独立于图像的观察者和中心偏差[14]。

5) Chance:给每个图像像素分配一个随机的均匀值,以构建显著性图。平均性能是在每个图像的5个这样的概率显著性映射上计算的。

?

?

?4 CHALLENGES AND OPEN PROBLEMS

在这里,我讨论了一些需要解决的挑战,以进一步缩小当前显著性模型与人类观察者间模型之间存在的差距。

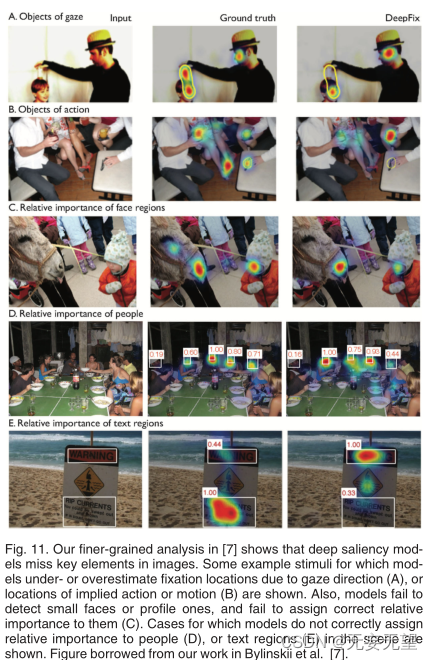

4.1 Characterizing the Errors of Models

正如我们所看到的,深度学习模型在显著性预测方面表现出了令人印象深刻的表现。然而,更深入的观察表明,他们仍然错过了图像中的关键元素。在Bylinskii等人[7]中,我们通过对图像类型、图像区域等进行细粒度分析,研究了最先进的图像显著性模型。我们进行了一项行为研究,在这项研究中,AMT工作者被要求标记(从15个选择中选出1个)位于注视热图前5%的图像区域。分析这些区域的模型失败表明,大约一半的模型错误是由于未能准确检测人,面孔,动物和文本的部分。这些区域在图像中具有最大的语义重要性(图A和11B)。

改善这种错误的一种方法是在更多的人脸实例(例如,部分的、模糊的、小的或遮挡的人脸、非正面视图)、更多的文本实例(不同的大小和类型)和动物上训练模型。显著性模型可能还需要在不同的任务中进行训练,以学习检测凝视和动作,并利用这些信息来显著性。

?

4.2 Mining Factors Driving Gaze during Free Viewing?

在自由观看中,已经发现了几个吸引凝视的线索[110],[111](例如,颜色,方向,强度,深度,运动,闪烁,纹理,惊讶,对称,稀缺性,面孔,文本,符号,物体,记忆,奖励,语义对象距离,凝视和指向方向[107],[112],情感价差,消失点[113],扩展焦点,文化差异,图像中心偏差,物体中心偏差[114],[115],场景背景),并已纳入显着性模型。

为了完全缩小人类IO模型和显著性模型之间的差距,在开发显著性模型的同时,还需要了解人类如何部署注意力(例如,通过进行行为研究)。换句话说,预测人们看哪里和理解注意力是不一样的。更好地理解人们的关注点使我们能够解释模型的作用,它们在哪里失败,以及如何改进它们。下面,我列举了一些需要进一步探索的方向。

Social Cues.?。众所周知,面孔和文字等线索以任务独立的方式吸引注视(例如,Cerf等[116])。人与人之间的社会互动和面部的精细属性,如情感、性别、面部模式、面部数量、面部大小、姿势、模糊、熟悉度、重要性和美感等,对它们的探索较少。这些都是经典显著性模型通常失败的典型例子[7]。在图像。现有的数据集,如CAT2000[117]、LFW[118]和人群场景[28],提供了一套丰富的刺激,可用于制定和测试几种针对社会线索的假设。一些问题包括:哪些面部成分吸引更多的注视?正面脸和侧面脸呢?脸和文字是如何影响凝视的?

Action Cues and Affordance。先前的研究表明,在执行日常任务(例如,操纵物体,到达[121])时,注视被驱动到与动作相关的区域。在自由观看时,动作是否也会引导注视,目前尚不清楚。通常情况下,动作线索会与其他线索混合在一起(例如,凝视方向)。因此,仔细地解开它们是很重要的。一种方法是设计一组专门的图像,其中对象被作用与不被作用时(即控制条件)类似于[50],[122]的方法,其中我们使用配对刺激。在自由观看中,一些可以引导固定的动作包括伸手、抓、扔、吃和踢。

Saliency, Importance, and Interestingness。这些因素已经在小图像集上进行了独立研究(例如,[123],[124],[125])。由于它们是非常主观的概念,因此,一致的、有原则的、全面的、大规模的调查可能会对它们的差异带来新的见解。

Elazary和Itti[124]是第一个在现有数据集(LabelMe)上研究兴趣和显著性的人。然而,他们的研究在两个方面受到限制。首先,他们的研究对象没有被分配明确的任务。因此,受试者可能会标记更容易的对象(小对象,因为它们更容易画出多边形),而不是有趣的对象。其次,他们只使用了Itti模型。如果使用更新的深度显著性模型来验证先前的结论是否适用于注视和点击,那将是一件有趣的事情。此外,个体差异和文化[126]、观看者性别[127]以及低水平显著性之外的其他假设(例如场景和物体意义[108])在预测凝视方面的作用需要进一步探索。

Objects versus Low-Level Saliency。自然场景中的显性注意力是由物体还是低层次图像特征引导的,这已经成为一个激烈争论的问题[115],[128],[129],[130]。基于对象的注意模型在预测注视方面与显著性模型相媲美。因此,研究它们与低水平显著性模型的关系是很重要的。最近的研究表明,观察者倾向于在物体中心附近注视(也称为首选观看位置PVL[114])。这是一种令人印象深刻的人类能力,但尚不清楚新的显著性模型是否也更加关注对象中心。为了获得洞察力,需要回答以下问题:1)人类和模型中的PVL是否也适用于倒置场景,线条图和模糊图像?2)物体大小和比例如何影响PVL?3)对称和对象中心偏差如何相关(例如,在Kootstra数据集[131]上),4)PVL如何与可操作区域和功能相关(例如,如[121]),以及5)PVL是否使用鼠标点击保持?

4.3 Explicit Saliency Judgments

Rudoy等人[132]和Jiang等人[22]首先利用显式显著性判断进行显著性建模。

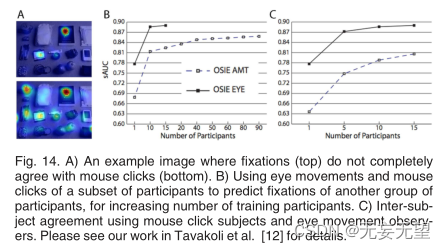

鼠标点击[22]、[132]和显著物体[9]已被证明与注视密切相关,尽管不完全相关。它们对于训练数据匮乏的深度模型也非常有用[16],[67]。然而,一些重要的问题仍然没有得到回答:a)点击是否可以完全取代固定,b)如果不能,从建模的角度来看,这意味着什么,以及如何最好地利用它们?

在[12]中,我们研究了注视和点击的相似性(图A)。我们对OSIE数据集[100]进行了两次分析。在第一种方法中,我们从OSIE AMT数据集中的鼠标跟踪数据中随机选择m名参与者,并构建鼠标密度图来预测眼球运动。我们发现,当使用10个观察者的眼球运动时,即使来自90个参与者的鼠标数据也无法达到相同的准确性,这表明鼠标跟踪和眼动追踪之间存在显著差距.

(图B)在第二次分析中,我们通过构建m个受试者的地图,并使用每种类型的数据(即观察者间模型)将其应用于其余受试者,从而测量了受试者间一致性。如图C所示,与眼动追踪参与者相比,鼠标追踪参与者之间存在更高的分散度。总而言之,尽管点击和注视之间的一致性很高,但仍然存在较小的差异:与注视相比,点击具有较低的参与者间一致性和较高的分散度。这一结果表明鼠标点击不能完全取代眼球运动。因此,我们只有两种选择:a)使用桌面眼动仪或网络摄像头进行大规模眼动追踪,或者b)从鼠标点击中收集良好的数据用于模型训练。我相信两者结合是更可行的策略.

?

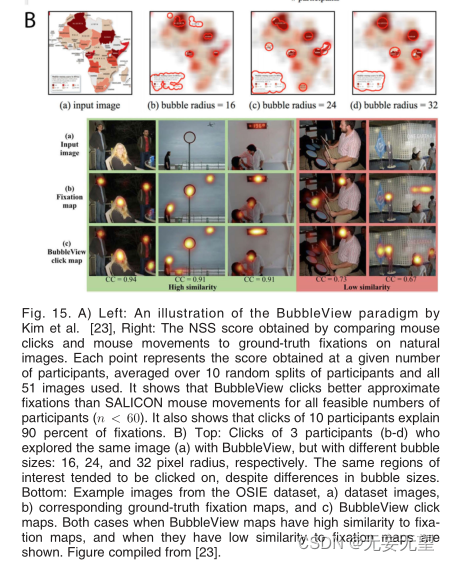

Kim等人[23]最近开发了一种名为BubbleView的技术,用于按比例收集图像上的点击数据。受试者会看到一张模糊的图像,并被要求依次点击区域,揭开场景背后的故事。

每次点击都会显示一个圆形图像区域。他们表明,与SALICON模式相比,这种策略产生了更好的数据,更接近实际的眼球运动。

他们还表明,10个参与者的点击可以解释90%的注视。如图15所示。虽然受试者可以正确地猜测人脸和文本等区域的凝视位置,但由于非平凡的潜意识线索(如空间异常值、凝视方向、消失点和对称性),他们是否也可以估计注意力和凝视,目前尚不清楚。解决这个问题的一种方法是将一些包含这些线索的图像(一次一个线索)穿插在没有这些线索的图像中(例如,户外自然场景,线条图)。同样有趣的是,研究1)是否可以训练受试者在提供反馈时更好地预测注视,2)使用触摸屏(如平板电脑,手机)是否可以产生更好的数据,因为使用它们时的运动运动与注视和触摸在同一个平面上比点击需要更少的努力,以及3)这些范例是否可以扩展到视频领域。

4.4 Invariance to Transformations?

为了在注视预测中真正接近人类水平的准确性,显著性模型应该能够在广泛的刺激范围内近似注视。传统上,研究人员采用直立图像来估计显著性。因此,在这些图像上训练的模型可能缺乏泛化。

在转换后的图像上探索注意力不仅提供了关于人类如何部署注意力的宝贵见解,还允许测试模型的泛化能力。

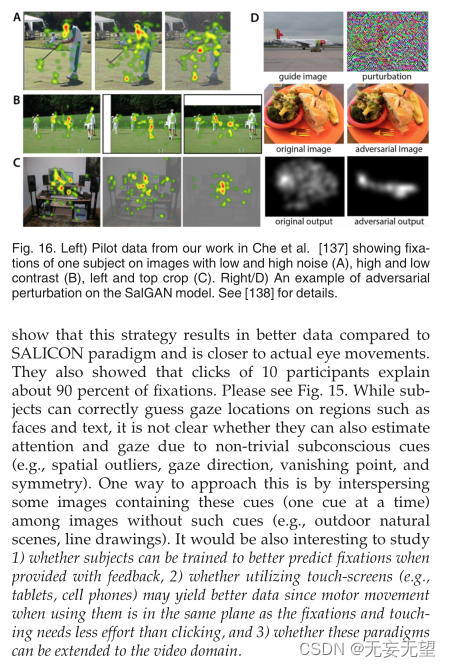

人类物体识别能力的标志是对旋转、尺度、光照、姿态和遮挡等变换的不变性。我认为,在对象识别文献中,当应用于转换后的图像时,显著性模型的表现应该与人类相似。之前的一些作品研究了对模糊[133],[134],嘈杂[134],[135]和低分辨率图像[134],[136]的注视。在初步调查[137]中,我们考虑了更大的转换阵列,包括水平翻转、剪切、裁剪、线条绘制、低对比度和高对比度、低和高运动模糊等(总共20个)。见图16。我们发现模型的性能在所有转换过程中都急剧下降。

为了建立不变显著性模型,需要回答以下几个问题:1)与原始刺激相比,自下而上的显著性和高层次因素(例如,情境、面孔)如何引导对转换图像的注视?2)在哪些转换主题之间更一致,3)相似程度如何点击和注视是在转换后的图像上,4)模型可以被训练来模仿人类在图像转换时的凝视吗?5)模型对对抗性扰动的鲁棒性如何(参见示例[138]和图16)。这项研究可以扩展到视频领域,通过调查其他因素的作用,如播放速度、观看理解与略读、反转和镜像,

?4.5 New Image Datasets

显著性数据集仍然比其他计算机视觉领域的数据集小几个数量级(例如,SALICON中的15,000张图像与imagenet中的100万张图像[61])。越来越大的数据集仍在出现。例如,Sun等人[139]收集了3亿张图像的数据集(JFT-300M),并表明在该数据集上训练的对象识别模型表现更好。受此启发,我相信未来对显著性的研究将从更多的数据中受益匪浅。下面列出了一些可能性。此外,更多的数据提供了可以比较模型的新维度

Natural Oddball Images and Camouflages。研究人员一直严重依赖于复杂的自然场景来训练显著性模型,并捕捉高层次和语义上的注意线索。少数作品(如[8])也在合成弹出式搜索数组上测试了模型(见图13)。像图17(上)所示的自然古怪的图像在很大程度上被忽略了。伪装图像,目标隐藏在杂乱的背景中(图17(底部)),也为测试模型提供了一组有趣的刺激。

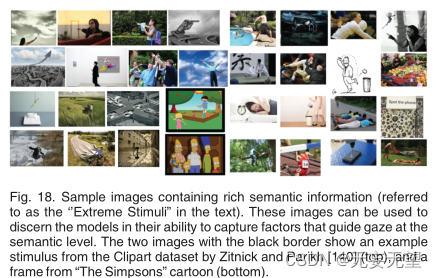

Extreme Stimuli。大多数现有的数据集是简单和困难的例子(相对于人类)的混合,以对模型进行一般评估,但这可能会产生不平衡的有偏见的估计,并对模型比较产生问题。一个模型可以很好地处理困难的情况,但在简单的情况下可能会失败,反之亦然。对所有类型的容易和困难刺激的平均精度隐藏了模型的优点和缺点。除了将模型应用于大量的各种测试图像之外,将它们与一组小而非常困难的图像进行比较,例如图18所示的图像,可以带来新的见解。当测量模型和人类之间的差距时,这样的数据集将特别有用,并且是及时的,因为显著性模型正在逐渐接近人类水平的精度。

这些图像至少可以通过两种方式收集:a)当眼动追踪数据可用时,最好的显著性模型严重失败;b)当只有明确的显著性判断可用时,记录图像上的眼球运动,受试者对凝视位置的猜测非常不一致。

Graphic Designs, Visualizations, and Web Pages.。在最近的一项研究中,Bylinskii等人[27]策划了一个众包图形设计和可视化的新数据集,并分析了显著性模型对基础真值重要性判断的预测(通过BubbleView范式收集;图19(左)。他们发现,目前的显著性模型表现不如专门训练用来预测该数据集上的注视的模型。在网页[30](图19(右))和人群场景[28]上也进行了类似的观察。收集新数据为显著性研究人员提供了建立特定领域模型的机会

4.6 Large Scale Video Data and Benchmark?

尽管最近在扩大视频显著性数据集的规模和多样性方面做出了努力(例如,DHF1K和Sal-360;图A和20B),可用的数据集仍然不足以涵盖在观看动态场景时可能引导凝视的所有线索(例如,语义概念、动作线索、主要演员、背景活动和情感内容)。例如,在自拍视频中,目光可能更多地指向与人的活动相关的动作和物体,而不是背景中发生的其他事情或人的脸。因此,仅突出显示面部区域的显著性模型不会表现良好。以下是一些新的视频数据类型。

Third-Person Videos and Cartoons。一种可能性是从UCF101[141]数据集中收集视频子集的凝视数据。该数据集包含来自101个动作类别的13320个YouTube视频。它包含高度的动作多样性和相机运动、物体外观和姿态、物体比例、视点、背景杂波、照明等方面的大变化。另一种可能性是从俯视图记录活动的无人机视频(例如VIRAT [142];图D).漫画和游戏等合成视频可以更多地强调可能吸引眼球的高级语义和认知线索。与自然场景相比,它们具有相对较低的可变性(例如,纹理,杂乱)。一些漫画带有字幕和音频,可以用来研究语言对注意力的影响,反之亦然(例如,“辛普森一家”;图18)。利用卡通的一个优点是,它们可以通过采用最先进的语义分割和对象检测模型进行注释。

First-Person and Selfie Videos.。第一人称视频带来了独特的挑战,如非静态摄像机、不寻常的视点、运动模糊、照明变化、摄像机佩戴者的不同位置以及实时视频分析要求。由于这些挑战,我们需要将它们与第三人称视频区别对待。在显著性的背景下,研究人们如何以被动的方式观看主动视频可以帮助建立更通用的视频显著性模型。这里可以使用的一些示例数据集包括ADL(日常生活活动[143])和Charades-Ego[144],如图e所示。这些数据集包含活动、物体轨迹、手部位置和交互事件等注释,可以对日常活动中的注视引导进行丰富的分析。最后,自拍视频(图F)提供了一个机会来研究面部、情绪和动作是如何在引导凝视时相互关联的。

Video Saliency Benchmark。视频显著性缺乏评估动态显著性模型和识别挑战的综合基准。这样的基准对于加速这一领域的未来研究是非常必要的。我们最近通过组织DHF1K基准测试(Wang等人[37])开始了这样的努力,该基准测试除了提供大型数据集外,还提供了一个公共评估服务器来比较保留测试集上的模型。然而,要普及,我们的努力需要社区的参与。

4.7 Fair Model Comparison and Scoring

评估模型缺乏共识一直是显著性进展的一大障碍[8],[102]。已经提出了几个分数,但每个分数都有不同的问题。例如,NSS分数倾向于在视觉上更符合人类注视的地图[11],但与AUC相似,它受到中心偏差的影响(Tatler[102])。虽然sac对中心偏见更有弹性,但它抛弃了很大一部分有价值的中心固定。这些缺点吸引了大量的研究来分析显著性措施的利弊(例如,[11])。

在最近的一项研究中,K€ummerer等[103]表明,当在相同的显著性图上评估度量时,不可能解决基准问题。为了解决这个问题,他们建议将模型、映射和度量的概念解耦,以比较模型。他们为最常用的测量(AUC, sAUC, NSS, CC, SIM, KL)导出了最佳显著性图,并表明这导致所有测量中的排名一致,并避免了对所有测量使用一个显著性图的惩罚(图A)。

K€summerer等人[65]得出结论,无论使用哪个分数,仍然可能存在较弱模型比最佳模型表现更好的图像。换句话说,较高的平均分并不意味着一个模型在所有情况下都能胜出。为了说明这一点,他们通过引入两个显著性模型,在两个不同的特征空间上使用相同的读出架构,比较了低特征和高级特征对显著性预测的预测能力。第一个是DeepGaze II,它使用了通过VGG学到的高级概念和特征。第二个模型称为ICF(强度对比特征),使用简单的强度对比特征。虽然DeepGaze II模型整体上明显优于低级ICF,但对于令人惊讶的大图像集,后者优于DeepGaze II(见图B)。

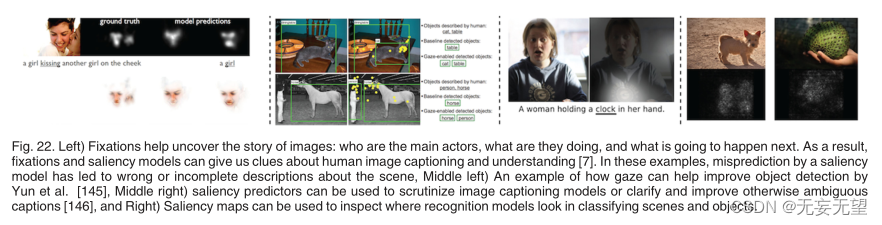

4.8 Relation to Other Domains and New Applications

深度学习的新进展(例如,gan[73])为显著性模型的新应用打开了大门(图22)。一些例子包括基于显著性的图像增强、压缩、cnn的可视化、图像绘制、显著性增强gan、图像和视频字幕[148]、视觉问答[149]、零射击图像分类[150]和患者诊断[151]。

在这里,我简要地描述了最近的两项工作,它们利用显著性进行基于神经网络的图像处理,或者使用神经网络加速显著性计算。在第一项研究中,Gatys等人[152]提出了一种自动调整图像的方法,以减弱干扰物,使感兴趣的物体更加突出(图23(左))。他们训练CNN变换图像,使其显著性映射符合给定的分布。对于网络训练,他们设计了一个损失函数来达到感知效果,同时保持变换后图像的自然性。在第二种方法中,Theis等人[153]使用密集网络和Fisher修剪,将显著性计算速度提高了10倍,同时获得与DeepGazeII相同的AUC分数(图23(右))。

5 DISCUSSION?

显著性建模是人类视觉和计算机视觉的交叉。因此,为了提高模型的性能,仅仅尝试新的架构是不够的。相反,重要的是研究人类如何看待场景,什么引导凝视,模型学习什么,以及它们在哪里失败。在这里,我强调了一些超越模型能力的方向。

The Need for Higher Level Visual Understanding。对MIT显著性基准测试中表现最好的模型进行细致的分析表明,它们都有共同的失败。深度显著性模型是很好的人脸和文本检测器,比它们的前辈要好得多。但是,与标记面部数据集上最先进的面部和文本检测器相比,它们有多好呢?同样,面部和文本检测器如何很好地解释固着,以及与面部和文本增强的经典显著性模型如何对抗深度显著性模型?从应用的角度来看,如果一个模型在人脸检测上做得很好,而忽略了人们不太关注的人脸,有时可能是可以接受或可取的。

即使是今天最好的显著性预测器也倾向于将不成比例的重要性放在文本和人身上,即使它们不一定是图像中语义上最有趣的部分。显著性模型将需要推断图像区域的相对重要性,例如关注房间中最重要的人或道路上信息量最大的标志(这取决于图像和上下文)。例如,在一个场景中有多个面孔的情况下,确定重要人物需要提取注视方向、身体姿势和个体的高级特征。同样,在图像中存在不同的文本区域时,有必要对含义进行一些高层次的理解(例如,警告标志是关于什么的?这本书是关于什么的?盒子里面是什么?为了获得更好的见解,可以进行实验室实验来评估人类如何优先考虑不同的线索(例如,文本和面孔),而不是为特殊目的设计的刺激(例如,自由观看,视觉搜索)。

简而言之,显著性模型仍然不能完全理解语义丰富场景中的高级语义(即“语义缺口”)。为了继续接近人类水平的表现,显著性模型需要在图像中发现越来越高级的概念:文本、凝视和动作的对象、运动的位置、图像中人物的预期位置,以及确定物体的相对重要性。认知注意力研究可以帮助克服这些限制。

Harvesting High Quality Data。收集约束、训练和评估注意力模型的数据是取得进展的关键。Bruce等人[10]指出,选择数据、创建基础真值和测量预测误差的方式(例如损失函数)对模型性能至关重要。大规模点击数据集[16],[23]对于训练深度模型和实现高精度非常有用。然而,点击偶尔会与固定不一致。因此,将好的点击声与有噪声的点击声分开,可以改善模型训练。此外,研究小鼠之间的差异运动和眼球运动,收集新类型的图像和视频数据,以及改进可用的数据集可能是有益的(例如,收集COCO/SALICON数据集上的注视)。

Multi-Modal and Multi-Label Data。来自不同模式(视觉、听觉、字幕等)或具有更丰富标签的数据可以帮助构建更具预测性的显著性模型。例如,Coutrot等人[39]表明,结合音频数据可以帮助预测视频的注视。Gorji & Clark[81],[95]和Recasens等[107]表明,使用凝视方向增强深度显著性模型可以在图像和视频上获得更高的性能。

最近,He等人[155]引入了一个包含字幕、音频和注视的数据集。多标签数据允许训练多任务网络,这可以导致比单个任务更好的性能。例如,显著性、字幕和视觉问答(VQA)的联合学习可以使三者都受益。一个领域(例如,VQA)中的现有数据集可以用其他任务的注释(例如,固定,标题)进行扩展。此外,由VQA或字幕模型生成的显著性图与显著性模型之间的相关性可以提供有关这些模型如何工作的见解。

Visualizing and Understanding Saliency Models。近年来,在理解cnn学习的用于场景和物体识别的表示方面取得了很大进展(例如,[155])。然而,我们对深度显著性模型所学到的知识的理解是有限的([156]是对这个问题的早期探索)。问题是显著性计算如何在深度显著性架构中出现,以及不同网络层的学习模式与对象识别的学习模式有何不同?探索这个问题的一种方法是观察同一个深度网络的内部,这个网络曾经接受过物体识别训练,也曾经接受过显著性预测训练,在同一组包含两种标签的刺激上:物体类别标签和显著性注释(例如,点击)。

Analysis of Evaluation Procedures.。最近在理解显著性评价措施方面取得了重大进展(例如,[11],[103])。AUC、NSS、SIM、KL和IG等指标更受青睐。

即使使用这些衡量标准,几种显著性方法也会在现有基准的顶端相互竞争,并且性能在一个狭窄的范围内变化。随着显著性模型数量的增加和模型之间得分差异的缩小,评估措施应调整为a)阐明模型和注视点之间的差异(例如,通过考虑空间和时间区域的相对重要性),以及b)减轻对地图平滑和中心偏差的敏感性。还有一种迫切需要设计合适的方法来比较视频显著性模型。作为测量的补充,细粒度的刺激,如集合或面板中的图像区域(如[7]中的图11所示,用于衡量模型预测图像内容相对重要性的程度)、心理物理模式(弹出式搜索数组和自然古怪场景)、转换后的图像以及极其困难的刺激可用于进一步区分模型性能。总之,与计算机视觉的其他领域(如gan[157])一样,显著性评估仍在发展中。

6 CONCLUSION

在过去的几年里,显著性预测的性能有了显著的提高,这在很大程度上要归功于深度监督学习和大规模的鼠标点击数据集。新的基于神经网络的模型以单一的端到端方式进行训练,将特征提取、特征集成和显著性值预测相结合,与传统的显著性模型相比,在性能上存在很大差距。这些显著性预测模型的成功表明,深度网络编码的高级图像特征(例如,对人脸、物体和文本的敏感性)以及cnn捕获全局上下文的能力对于预测注视位置非常有用。然而,新的深度显著性模型仍然存在一些需要解决的缺点,以达到人类水平的准确性。对模型失效的分析可以帮助我们设计出新的更好的模型,从而在性能上实现下一个质的飞跃。

在这篇综述中,我涵盖了大量最近在显著性预测方面的工作,并提出了未来研究的几个途径。尽管付出了巨大的努力和取得了巨大的进步,但在深度显著性模型的细粒度分析、理解模型和评估程序、数据集、任务、注释方法、认知注意力研究和应用等方面仍有改进的空间

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!