Pytorch当中的.detach()操作是什么意思

2023-12-16 11:00:50

.detach() 是 PyTorch 中用于从计算图中分离张量的方法。当我们在PyTorch中进行张量运算时,操作会构建一个计算图来跟踪计算历史,这个计算图用于自动求导和反向传播来计算梯度。

使用.detach()方法可以将一个张量从当前的计算图中分离出来,使其变成一个不再需要梯度追踪的普通张量,即使它是由需要梯度的操作创建的。这样做有时可以避免梯度传播,也可以用于获取不需要梯度的张量副本。

例如,在神经网络训练中,如果只是需要使用某个张量的值而不需要对其进行梯度计算,可以使用.detach()方法分离该张量,然后将其转换为NumPy数组或进行其他操作,而不会影响梯度传播。

示例代码如下:

import torch

# 创建一个需要梯度追踪的张量

x = torch.tensor(2.0, requires_grad=True)

# 进行一些计算

y = x ** 2

z = y * 3

# 分离张量z,得到一个不再需要梯度的普通张量

detached_z = z.detach()

# 对变量z进行反向传播

z.backward()

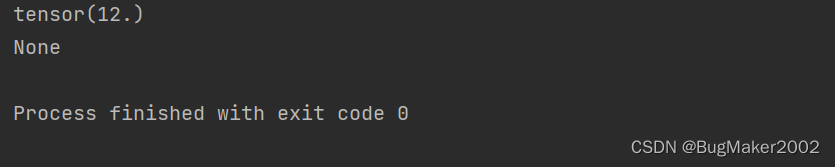

print(x.grad) # 输出梯度,因为z有梯度追踪,所以x的梯度为 12.0

# 但是detached_z已经被分离,不再需要梯度

print(detached_z.grad) # 此行代码会输出None,因为detached_z不再具有梯度追踪

输出为:

文章来源:https://blog.csdn.net/m0_57317650/article/details/135029024

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!