大数据从入门到精通(超详细版)之HDFS的操作,点开之前没想到这么简单 !!!

前言

嗨,各位小伙伴,恭喜大家学习到这里,不知道关于大数据前面的知识遗忘程度怎么样了,又或者是对大数据后面的知识是否感兴趣,本文是《大数据从入门到精通(超详细版)》的一部分,小伙伴们如果对此感谢兴趣的话,推荐大家按照大数据学习路径开始学习哦。

以下就是完整的学习路径哦。

↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓

↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑ ↑

推荐大家认真学习哦!!!

文章目录

前面我们已经安装完了HDFS,相信大家已经对HDFS的理解已经更加深入了,来到本篇文章,我们将学习HDFS的操作,在实战当中学会如何应用HDFS。

HDFS的集群命令

启动HDFS

Hadoop HDFS组件内置了HDFS集群的一键启停脚本。

$HADOOP_HOME/sbin/start-dfs.sh,一键启动HDFS集群

执行原理:

- 在执行此脚本的机器上,启动

SecondaryNameNode - 读取

core-site.xml内容(fs.defaultFS项),确认NameNode所在机器,启动NameNode - 读取

workers内容,确认DataNode所在机器,启动全部DataNode

$HADOOP_HOME/sbin/hadoop-daemon.sh , 单独启动一个节点

此脚本可以单独控制所在机器的进程的启停用法:

hadoop-daemon.sh (start|status|stop) (namenode|secondarynamenode|datanode)

停止HDFS

$HADOOP_HOME/sbin/stop-dfs.sh,一键关闭HDFS集群

执行原理:

- 在执行此脚本的机器上,关闭

SecondaryNameNode - 读取

core-site.xml内容(fs.defaultFS项),确认NameNode所在机器,关闭NameNode - 读取

workers内容,确认DataNode所在机器,关闭全部NameNode

$HADOOP_HOME/bin/hdfs, 此程序也可以用以单独控制所在机器的进程的

启停用法:

hdfs --daemon (start|status|stop) (namenode|secondarynamenode|datanode)

文件操作系统命令

我们先介绍一下HDFS文件系统的的路径表达式:

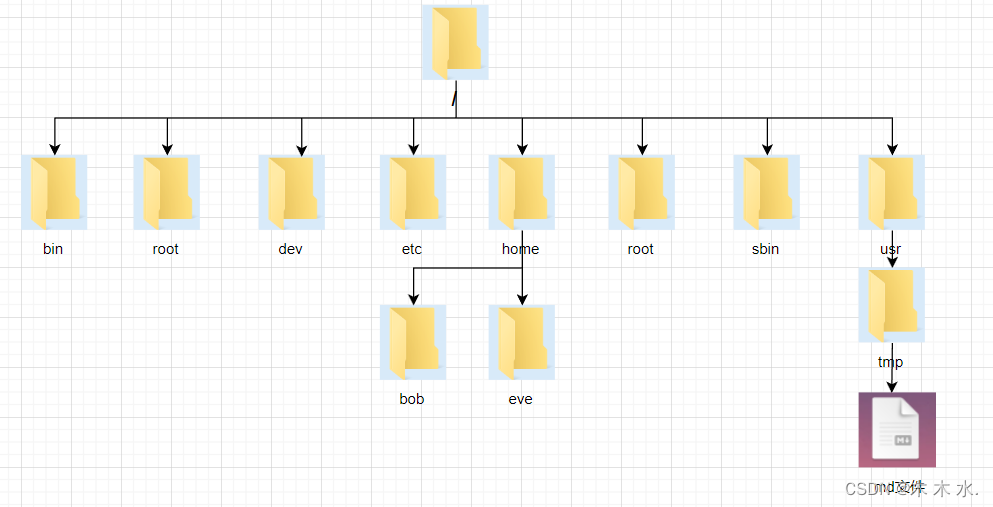

HDFS文件系统基本信息

HDFS同Linux系统一样,均是以/作为根目录的组织形式

Linux和Hdfs文件的协议名如下 :

Linux:file:///HDFS:

hdfs://namenode:port/

协议头file:/// 或 hdfs://node1:8020/可以省略

- 需要提供Linux路径的参数,会自动识别为file://

- 需要提供HDFS路径的参数,会自动识别为hdfs://

除非你明确需要写或不写会有BUG,否则一般不用写协议头

就只有协议头存在区别 , 其他都不会存在区别

操作命令体系

关于HDFS文件系统的操作命令,Hadoop提供了2套命令体系

- hadoop命令(老版本用法),用法:

hadoop fs [generic options] - hdfs命令(新版本用法),用法:

hdfs dfs [generic options]

两者在文件系统操作上,用法完全一致用哪个都可以

本文使用 hdfs命令(新版本用法)。

创建文件夹

hdfs dfs -mkdir [-p] <path> ...

path为待创建的目录-p选项的行为与Linuxmkdir -p一致,它**会沿着路径创建父目录。**

查看指定目录下内容

hdfs dfs -ls [-h] [-R] [<path> ...]

path指定目录路径-h人性化显示文件size-R递归查看指定目录及其子目录

上传文件到HDFS指定目录下

hdfs dfs -put [-f] [-p] <localsrc> ... <dst>

-f覆盖目标文件(已存在下)-p保留访问和修改时间,所有权和权限。localsrc本地文件系统(客户端所在机器)dst目标文件系统(HDFS)

查看HDFS文件内容

hdfs dfs -cat <src> ...

读取大文件可以使用管道符配合more

hdfs dfs -cat <src> | more

下载HDFS文件

hadoop fs -get [-f] [-p] <src> ... <localdst>

- 下载文件到本地文件系统指定目录,localdst必须是目录

-f覆盖目标文件(已存在下)-p保留访问和修改时间,所有权和权限。

拷贝HDFS文件

hdfs dfs -cp [-f] <src> ... <dst>

-f 覆盖目标文件(已存在下)

追加数据到HDFS文件中

hdfs dfs -appendToFile <localsrc> ... <dst>

- 将所有给定本地文件的内容追加到给定dst文件。

- dst如果文件不存在,将创建该文件。

- 如果为-,则输入为从标准输入中读取。

HDFS数据移动操作

hdfs dfs -mv <src> ... <dst>

- 移动文件到指定文件夹下

- 可以使用该命令移动数据,重命名文件的名称

HDFS数据删除操作

hdfs dfs -rm -r [-skipTrash] URI [URI ...]

- 删除指定路径的文件或文件夹

- -skipTrash 跳过回收站,直接删除

以上就是最经常使用的命令了,小伙伴们一定要经常使用哦,熟能生巧这句话一定要牢记在心哦

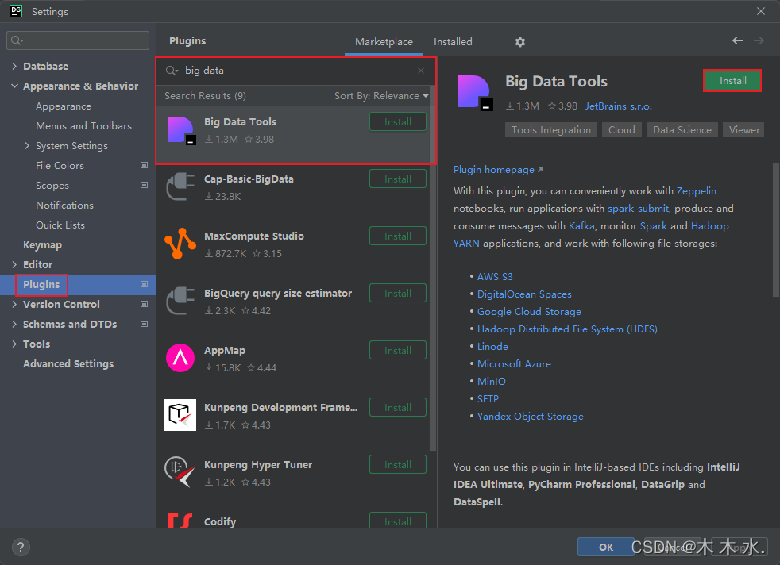

Big Data Tools插件

安装

在Jetbrains的产品中,均可以安装插件,其中:**Big Data Tools**插件可以帮助我们方便的操作HDFS,比如

- IntelliJ IDEA(Java IDE)

- PyCharm(Python IDE)

- DataGrip(SQL IDE)

均可以支持Bigdata Tool插件。

如图,在设置->Plugins(插件)-> Marketplace(市场),搜索Big Data Tools,点击Install安装即可

配置Windows :

- 需要对Windows系统做一些基础设置,配合插件使用

- 解压Hadoop安装包到Windows系统,如解压到:E:\hadoop-3.3.4

- 设置$HADOOP_HOME环境变量指向:E:\hadoop-3.3.4

下载

- hadoop.dll(https://github.com/steveloughran/winutils/blob/master/hadoop-3.0.0/bin/hadoop.dll)

- winutils.exe(https://github.com/steveloughran/winutils/blob/master/hadoop-3.0.0/bin/winutils.exe)

将hadoop.dll和winutils.exe放入$HADOOP_HOME/bin中

结尾

恭喜小伙伴完成本篇文章的学习,相信文章的内容您已经掌握得十分清楚了,如果您对大数据的知识十分好奇,请接下来跟着学习路径完成大数据的学习哦,相信你会做到的~~~

↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓ ↓

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!