MHF-Net(CVPR2019,TPAMI2020):一种可解释的光谱融合网络

MHF-Net

Paper:MHF-Net: An Interpretable Deep Network for Multispectral and Hyperspectral Image Fusion

Code:MHF-net: tpami,cvpr

简介

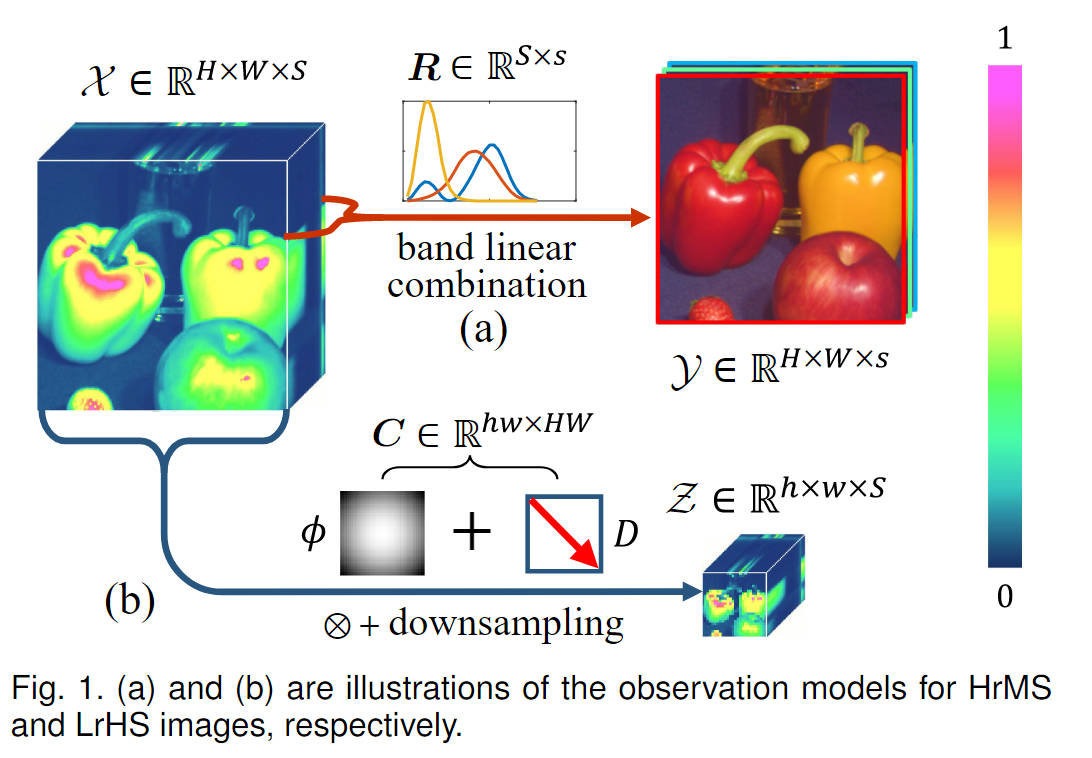

? 在光谱融合超分的领域中,现有传统方法极大依赖于手工先验知识,造成大量的主观性问题,而基于深度学习的方法,只是利用了通用图像超分的框架进行的处理,不具有很好的可解释性。

? 基于此,本论文从融合模型下手,通过将模型使用神经网络进行优化求解,让提出的MHF-net的每个模块都具有其自己的物理意义。在网络架构基础上,还针对训练数据和测试数据响应矩阵不匹配的问题进行了单独设计。

现阶段问题

-

即使已知R,C从退化的数据立方体转为三维数据立方体是ill-posed问题(不存在唯一解的问题)

- 在传统的无监督方法中,有必要将X背后的先验结构数学编码为正则化器

- 具体来说,在传统的无监督 MS/HS 融合方法中,通常需要在 X 上预先假设先验作为解决问题的正则化器,例如,早期的MS/HS融合技术继承了泛锐化原理,用小波级数展开[14]、[61]表示HS图像。然后,假设 HS 图像的空间信息可以在学习的字典 [2]、[15]、[63] 下稀疏表示,进一步利用 HS 图像上的空间稀疏表示来完成任务。此外,[31] 在 HrHS 图像上采用局部空间平滑度,并在他们的模型中使用总变化 (TV) 正则化。最近的一些方法不是从 HrHS 探索空间先验知识,而是假设 HrHS 上具有更多的内在光谱相关性,并采用低秩矩阵分解技术沿光谱 [54] [62] [30] 对此类先验进行编码。

- 合理性依赖于手动强加于未知 HrHS 的先验假设来恢复,这些具有主观和相对简单的形式的手工先验总是不能充分和自适应地反映真实HSIs背后的内在复杂空间和光谱配置

-

缺乏可解释性、偏离先验配置:

- 现有的DL方法基本是通用超分架构,忽略了生成HrHS的内在理解,缺乏可解释性。

- 忽略了一般HS图像明显拥有的先验知识结构,如光谱低秩性。这可能会导致网络输出偏离一般先验配置,从而影响恢复精度,

主要贡献

-

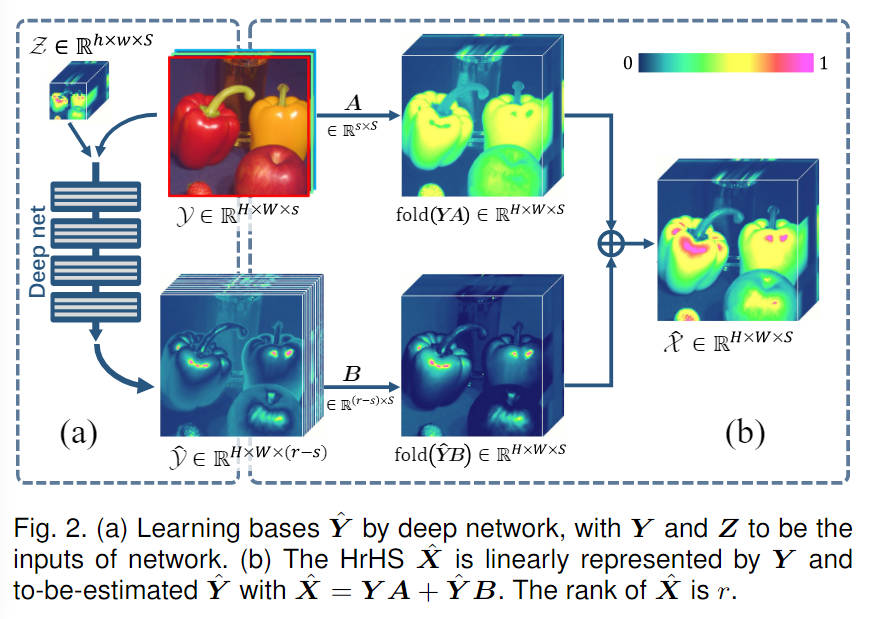

充分考虑MS/HS融合的内在生成机制的DL方法,使用Y的完整基集进行计算,网络所有模块都具有可解释性

-

考虑了训练和测试阶段响应不同的问题,将响应也作为网络输入进行模型的训练

模型优化

Z = C ( Y A + Y ^ B ) + N Z=C(YA+\hat{Y}B)+N Z=C(YA+Y^B)+N

设计优化问题:

min

?

Y

^

∥

C

(

Y

A

+

Y

^

B

)

?

Z

∥

F

2

+

λ

f

(

Y

^

)

,

\min_{\hat{\boldsymbol{Y}}}\left\|C\left(YA+\hat{Y}B\right)-Z\right\|_F^2+\lambda f\left(\hat{\boldsymbol{Y}}\right),

Y^min?

?C(YA+Y^B)?Z

?F2?+λf(Y^),

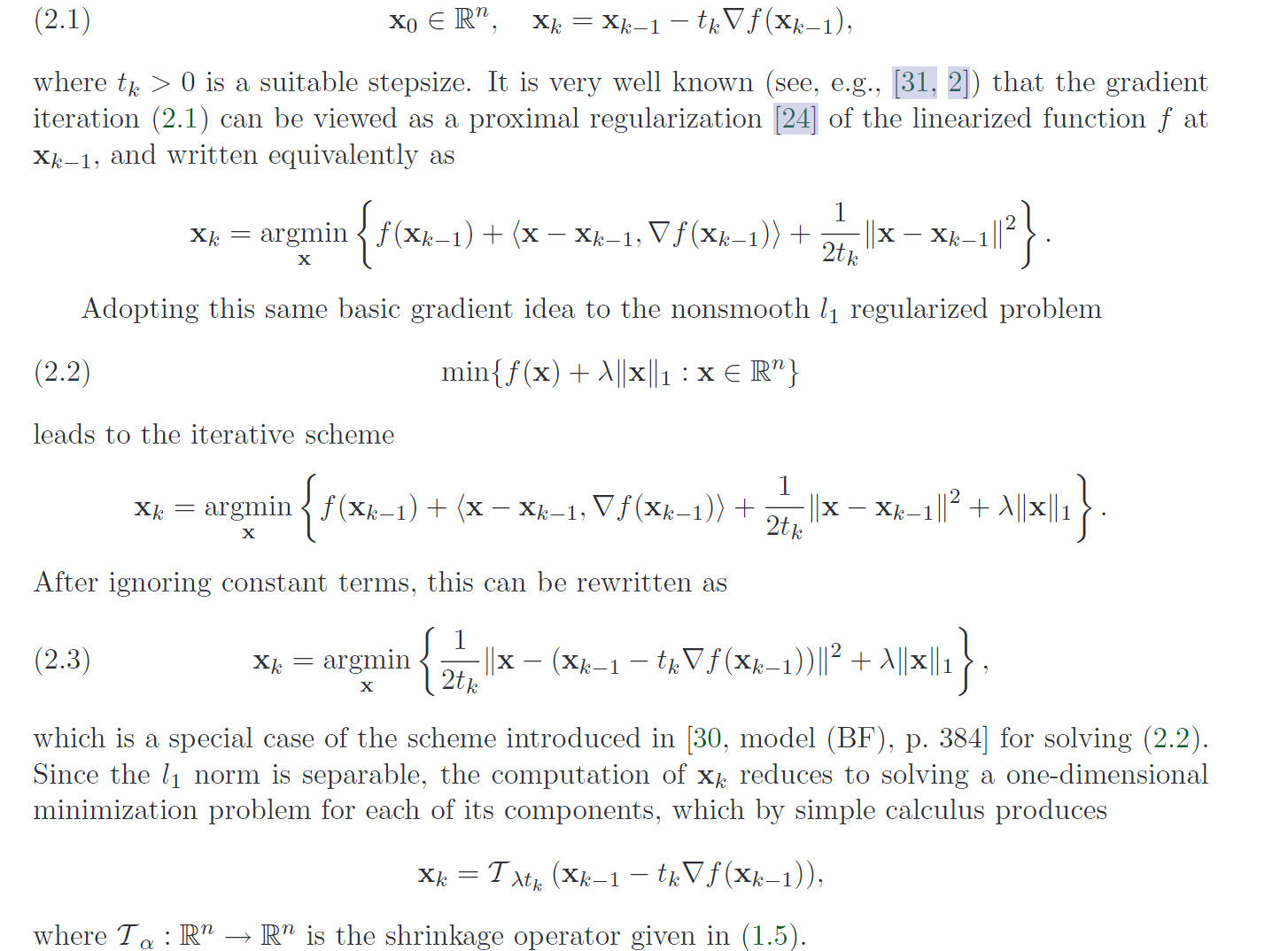

采用proximal gradient algorithm进行参数更新

其中

Q

(

Y

^

,

Y

^

(

k

)

)

Q(\hat{Y},\hat{Y}^{(k)})

Q(Y^,Y^(k))是二阶近似:

f

(

x

)

≈

f

(

x

0

)

+

f

′

(

x

0

)

(

x

?

x

0

)

+

f

′

′

(

x

0

)

(

x

?

x

0

)

2

2

f(x)\approx f(x_0)+f^{\prime}(x_0)(x-x_0)+f^{\prime\prime}(x_0)\frac{(x-x_0)^2}2

f(x)≈f(x0?)+f′(x0?)(x?x0?)+f′′(x0?)2(x?x0?)2?

Q

(

Y

^

,

Y

^

(

k

)

)

=

g

(

Y

^

(

k

)

)

+

<

Y

^

?

Y

^

(

k

)

,

?

g

(

Y

^

(

k

)

)

>

+

1

2

η

∥

Y

^

?

Y

^

(

k

)

∥

F

2

+

λ

f

(

Y

^

)

,

\begin{aligned} Q\left(\hat{\boldsymbol{Y}},\hat{\boldsymbol{Y}}^{(k)}\right)& =g\left(\hat{\boldsymbol{Y}}^{(k)}\right)+\left<\hat{\boldsymbol{Y}}-\hat{\boldsymbol{Y}}^{(k)},\nabla g\left(\hat{\boldsymbol{Y}}^{(k)}\right)\right> \\ &+\frac1{2\eta}\left\|\hat{Y}-\hat{Y}^{(k)}\right\|_{F}^{2}+\lambda f\left(\hat{Y}\right), \\ \end{aligned}

Q(Y^,Y^(k))?=g(Y^(k))+?Y^?Y^(k),?g(Y^(k))?+2η1?

?Y^?Y^(k)

?F2?+λf(Y^),?

其中

g

(

Y

^

(

k

)

)

=

∥

C

(

Y

A

+

Y

^

(

k

)

B

)

?

Z

∥

F

2

g(\hat{Y}^{(k)})=\|C(YA+\hat{Y}^{(k)}B)-Z\|_{F}^{2}

g(Y^(k))=∥C(YA+Y^(k)B)?Z∥F2?同时

η

\eta

η作为步长的角色

A Fast Iterative Shrinkage-Thresholding Algorithm for Linear Inverse Problems

根据上图,将优化问题转化为:

min

?

Y

^

1

2

∥

Y

^

?

(

Y

^

(

k

)

?

η

?

g

(

Y

^

(

k

)

)

)

∥

F

2

+

λ

η

f

(

Y

^

)

.

\min_{\hat{\boldsymbol{Y}}}\frac{1}{2}\left\|\hat{\boldsymbol{Y}}-\left(\hat{\boldsymbol{Y}}^{(k)}-\eta\nabla g\left(\hat{\boldsymbol{Y}}^{(k)}\right)\right)\right\|_{F}^{2}+\lambda\eta f\left(\hat{\boldsymbol{Y}}\right).

Y^min?21?

?Y^?(Y^(k)?η?g(Y^(k)))

?F2?+ληf(Y^).

同时,其通解写为:

Y

^

k

+

1

=

p

r

o

x

λ

η

(

Y

^

(

k

)

?

η

?

g

(

Y

^

(

k

)

)

)

\hat{Y}^{k+1}=prox_{\lambda\eta}(\hat{\boldsymbol{Y}}^{(k)}-\eta\nabla g(\hat{\boldsymbol{Y}}^{(k)}))

Y^k+1=proxλη?(Y^(k)?η?g(Y^(k)))

又因为

?

g

(

Y

^

(

k

)

)

=

C

T

[

C

(

Y

A

+

Y

(

k

)

B

?

Z

]

B

T

\nabla g(\hat{Y}^{(k)})=C^{T}\left[C\left(Y A+Y^{(k)}B-Z\right] B^{T}\right.

?g(Y^(k))=CT[C(YA+Y(k)B?Z]BT

就可以将prox函数式子转为:

Y

^

k

+

1

=

p

r

o

x

λ

η

(

Y

^

(

k

)

?

η

C

T

(

C

(

Y

A

+

Y

(

k

)

B

)

?

Z

)

B

T

)

\hat{Y}^{k+1}=prox_{\lambda\eta}\left(\hat{\boldsymbol{Y}}^{(k)}-\eta C^{T}\left(C\left(Y A+Y^{(k)}B\right)-Z\right) B^{T}\right)

Y^k+1=proxλη?(Y^(k)?ηCT(C(YA+Y(k)B)?Z)BT)

求解 ? g ( Y ^ ( k ) ) \nabla g(\hat{Y}^{(k)}) ?g(Y^(k))

A Fast Iterative Shrinkage-Thresholding Algorithm for Linear Inverse Problems

矩阵的 Frobenius 范数及其求偏导法则_f范数求导-CSDN博客

KaTeX parse error: Undefined control sequence: \tr at position 85: …=\operatorname{\?t?r?} \left( \left …

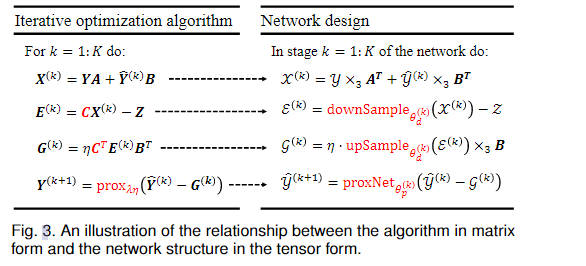

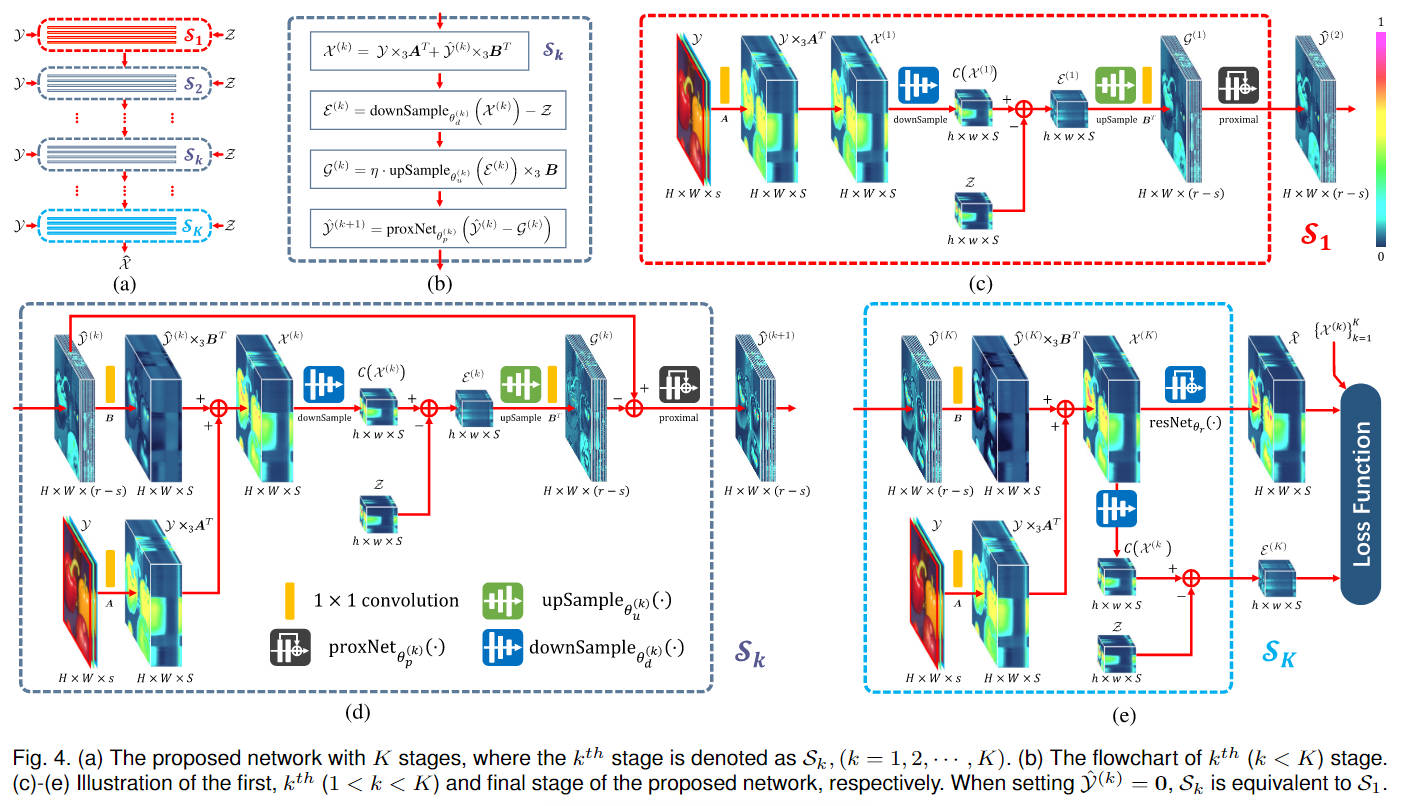

网络设计

? 由

X

X

X是高分辨率图像,将其变为

E

E

E为低分辨率图像,可以将

C

C

C理解为一个下采样操作,反之

C

T

C^T

CT则为上采样操作,对于

p

r

o

x

λ

η

prox_{\lambda\eta}

proxλη?可以将其看为一个复杂的仿射变换,比作一个神经网络操作。

X

(

k

)

=

Y

A

+

Y

^

(

k

)

B

,

E

(

k

)

=

C

X

(

k

)

?

Z

,

G

(

k

)

=

η

C

T

E

(

k

)

B

T

,

Y

^

(

k

+

1

)

=

p

r

o

x

λ

η

(

Y

^

(

k

)

?

G

(

k

)

)

.

\begin{gathered} X^{(k)}=YA+\hat{Y}^{(k)}B, \\ E^{(k)}=CX^{(k)}-Z, \\ G^{(k)}=\eta C^{T}E^{(k)}B^{T}, \\ \hat{\boldsymbol{Y}}^{(k+1)}=\mathrm{prox}_{\lambda\eta}\left(\hat{\boldsymbol{Y}}^{(k)}-\boldsymbol{G}^{(k)}\right). \end{gathered}

X(k)=YA+Y^(k)B,E(k)=CX(k)?Z,G(k)=ηCTE(k)BT,Y^(k+1)=proxλη?(Y^(k)?G(k)).?

对于Blind Fusion NET的探索

? 将响应矩阵R,C的相关参数也作为模型的输入,其中A,B,C参数都可以从已有训练数据中通过基于模型的方法进行求解估计得到。

? 在训练过程中,对于每个训练样本进行参数估计,将其输入到模型进行训练。在测试阶段,同样是先进行参数估计,再进行输入。通过这种方式,网络有望捕获不同输入光谱和空间响应的一般恢复原理。

? 需要注意的是,此处网络在下采样和上采样过程中,不能简单使用原有的,需要根据求出的参数进行变化。

相关deep unrolling 文献

将优化问题转为神经网络进行求解

[1]W. Dong, P. Wang, W. Yin, G. Shi, F. Wu, and X. Lu, “Denoising Prior Driven Deep Neural Network for Image Restoration,” IEEE Transactions on Pattern Analysis and Machine Intelligence, pp. 2305–2318, Oct. 2019, doi: 10.1109/tpami.2018.2873610.

[1]L. Wang, C. Sun, Y. Fu, M. H. Kim, and H. Huang, “Hyperspectral Image Reconstruction Using a Deep Spatial-Spectral Prior,” in 2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR), Long Beach, CA, USA, Jun. 2019. doi: 10.1109/cvpr.2019.00822.

[1]D. Yang and J. Sun, “Proximal Dehaze-Net: A Prior Learning-Based Deep Network for Single Image Dehazing,” in Computer Vision – ECCV 2018,Lecture Notes in Computer Science, 2018, pp. 729–746. doi: 10.1007/978-3-030-01234-2_43.

[1]Y. Yang, J. Sun, H. Li, and Z. Xu, “Deep ADMM-Net for compressive sensing MRI,” Neural Information Processing Systems,Neural Information Processing Systems, Dec. 2016.

[1]J. Zhang and B. Ghanem, “ISTA-Net: Interpretable Optimization-Inspired Deep Network for Image Compressive Sensing,” in 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition, Salt Lake City, UT, Jun. 2018. doi: 10.1109/cvpr.2018.00196.

[1]J. Zhang, J. Pan, W.-S. Lai, RynsonW. H. Lau, and M.-H. Yang, “Learning Fully Convolutional Networks for Iterative Non-blind Deconvolution,” Cornell University - arXiv,Cornell University - arXiv, Nov. 2016.

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!