针对人工智能的攻击并发布策略和建议

2024-01-07 22:02:00

人工智能系统已经渗透到现代社会的各个领域。从自动驾驶到疾病诊断以及作为在线聊天机器人与客户互动。

为了学习如何执行这些任务,聊天机器人需要接受大量数据的训练。然而,主要问题之一是这些数据可能不可靠。攻击者有很多机会破坏它们。这都是在AI系统的训练期间和训练之后。

如果对手找到一种方法来混淆人工智能系统的决策,那么人工智能系统可能会表现不佳。(来源美国国家标准技术研究所)

美国国家标准与技术研究院 (NIST) 发布了?一份建议清单。这些建议有助于了解如何应对旨在操纵人工智能系统行为的网络攻击。每种类型的攻击都在单独的科学著作中进行了详细讨论。标题是“对抗性机器学习:攻击和补救的分类和术语”。

针对人工智能模型的主要攻击

NIST 研究人员发现了以下类型的攻击可以操纵人工智能系统的功能。

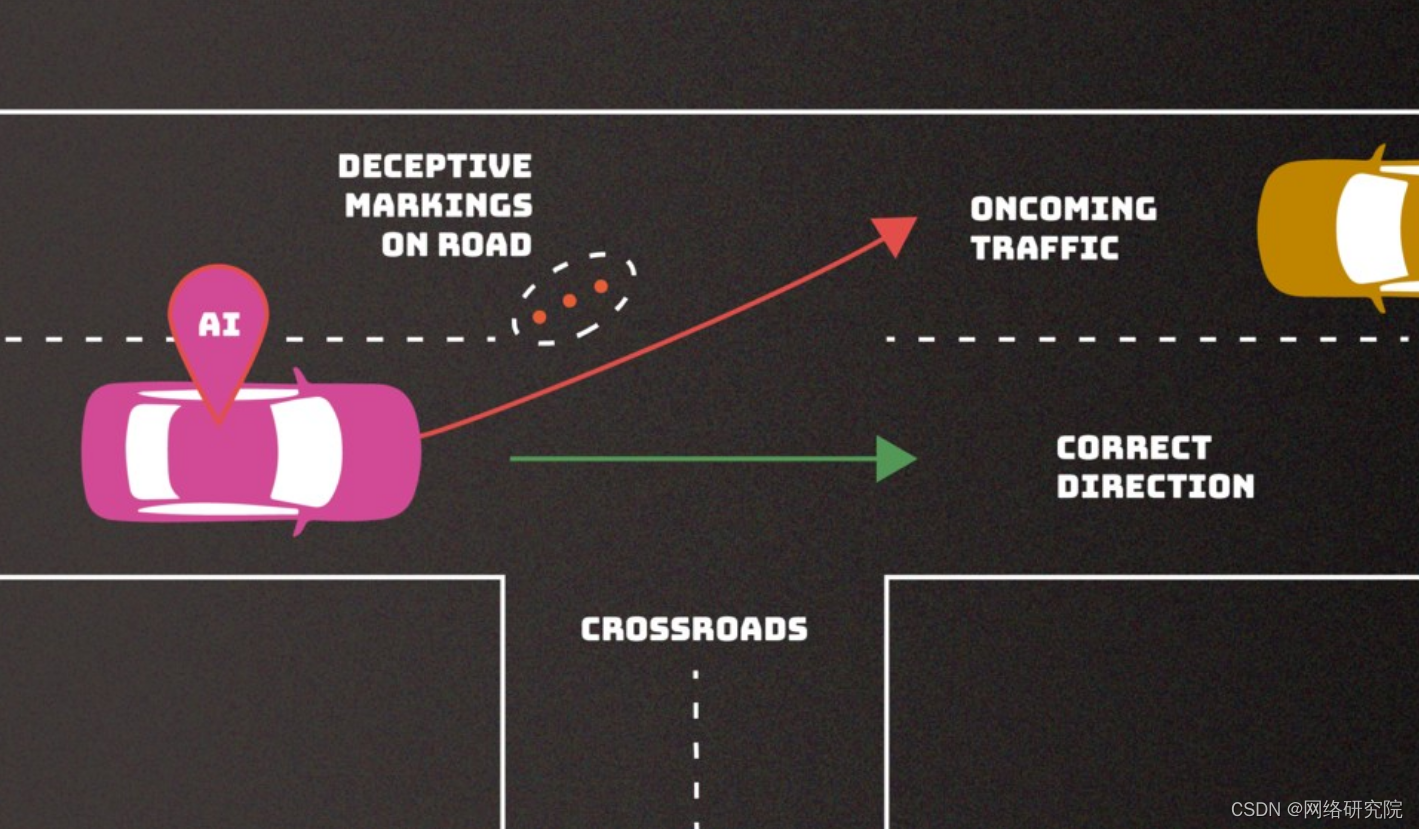

- 躲避攻击:这些攻击发生在人工智能系统实施之后。他们的目的是修改输入数据以扭曲系统的响应。例如,物理扭曲道路标志,使自动驾驶汽车误解它们,并可能误读一段道路的速度限制或以其他方式造成紧急情况;

- 中毒攻击:这些攻击是在人工智能训练阶段进行的,当时故意将有偏见的信息引入到训练数据中。例如,在对话录音中包含大量淫秽语言,以便聊天机器人开始将淫秽语言视为与客户互动时使用的规范。重新开发模型的声誉风险和成本可能使此类攻击对许多公司极具破坏性;

- 对隐私的攻击:这些攻击发生在系统使用过程中,旨在提取有关人工智能系统本身的敏感信息或其所训练的数据,以供后续滥用。例如,攻击者可以向聊天机器人提出一系列合理的问题,然后使用答案来重建模型,以揭示其弱点或有关其信息源的假设;

- 滥用攻击:这些攻击涉及将不正确的信息插入到源中,例如网页或在线文档,然后人工智能将其视为有效。与投毒不同,滥用攻击的目标是人工智能模型实时访问的内容,例如通过搜索引擎。此类攻击试图从合法但受损的来源向人工智能提供不正确的信息,以改变人工智能系统的预期用途。

大多数此类攻击都很容易发动,他们只需要对人工系统有很少的了解。?

风险缓解从控制和协作开始

为了减轻与人工智能系统操纵相关的威胁,NIST 专家推荐了一种综合方法。

这包括对人工智能系统进行广泛的测试和持续更新,持续监控输入数据和系统反应,开发专门的算法来检测攻击,创建多层保护和备份系统,与专家社区合作分享相关知识和信息新的威胁,以及提高认识并培训使用人工智能的员工。?

这些措施旨在最大限度地降低风险并提高人工智能系统对上述形式的操纵攻击的抵抗力。

NIST 报告不仅揭示了利用人工智能相关的潜在风险,还鼓励开发人员和研究人员寻找新的、更有效的方法来保护自己。这反过来又有助于开发更安全的数字空间,人工智能可以在不受外部操纵和滥用威胁的情况下为社会服务,同时保持所处理数据的完整性和机密性。

文章来源:https://blog.csdn.net/qq_29607687/article/details/135432841

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!