GPT2代码运行,个人文本生成助手,不依赖OpenAI API调用

0.前言: 感觉GPT很好玩,所以想要有个自己搭建GPT的写法,不依赖于OpenAI,需要翻墙太麻烦了,近日日本已经结合GPT4和机器,可以让他吓人,做出丰富的表情,如果自己训练的话,会塑造出什么样的机器人尚未可知…抱着好奇的心态,去github openai下载了个gpt2的模型来玩玩(其中遇到了许多坑),也尝试过其他开源的gpt模型(autogpt(还是调用openai的接口,但是以后可能在个人电脑上一键生成项目),gptfree,gpt4all也是调用api,chinesegpt中文模型可以生成但是慢),奈何对电脑的要求太高了,使用2的话可塑性比较强,而且我想要的是大家的电脑都能用上…

//日本机器人模仿表情

1.官方gpt2项目地址

2.由于官方使用docker部署的,所以他使用了 python3这个镜像,我们是使用windows来运行的,遇到了许多坑,python版本他们没有给,只能自己调试出来

//我想起了进行java编程maven引入依赖经常出现不兼容的问题,那我可以通过他给的几个版本号来间接推理出其他的版本,假设springboot是3.x,我可以去官网看看他们对应的版本关系,然后在慢慢调试让程序运行起来…

//下面是项目调试后的版本 改掉requirements.txt的内容 python3.7

fire==0.5.0

regex==2023.10.3

TensorFlow==1.13.1

protobuf==3.6.1

requests==2.21.0

tqdm==4.31.1

//安装依赖

pip3 install -r requirements.txt

3.使用

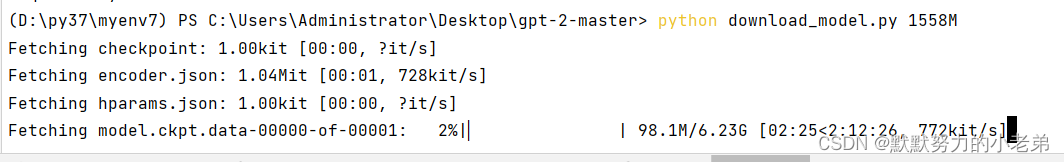

//根据DEVELOPERS.md的说明安装model,官方说了这个项目是给学者研究的,你可以选择任意一个模型来下载,我下载了124M的回答效果很一般emmm

python download_model.py 124M

python download_model.py 355M

python download_model.py 774M

python download_model.py 1558M

//unconditional_samples其实就是你不给他文本他随意生成文本

//使用管道符,把内容生成为一个文本

python src/generate_unconditional_samples.py | tee C:\samples.txt

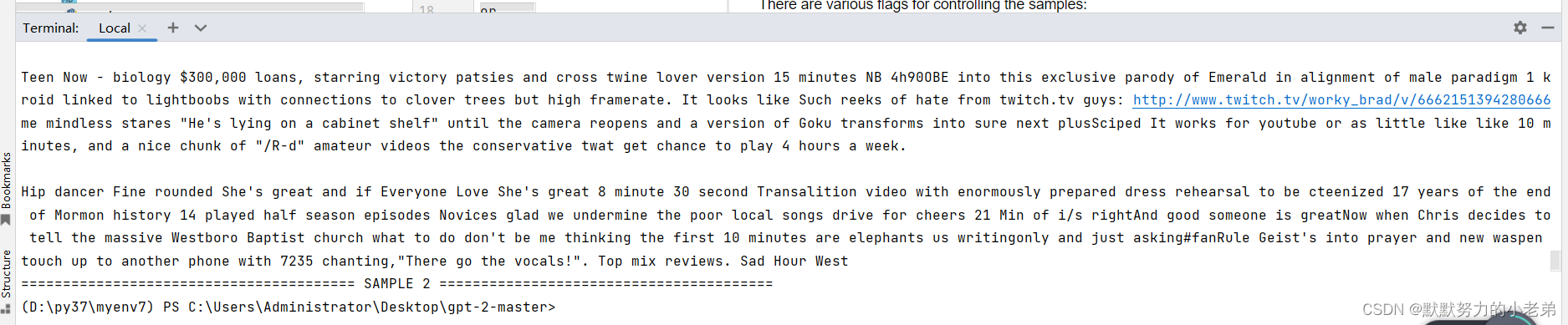

//效果,语义挺连贯的 He’s lying on a cabinet shelf" until the camera

reopens and a version of Goku transforms into sure next plusSciped It works for youtube

//缺点是生成的时间太长了使用cpu的话,再看看能不能使用gpu来生成会不会好一点

4.使用对话式生成,unconditional

python src/generate_unconditional_samples.py -- --help

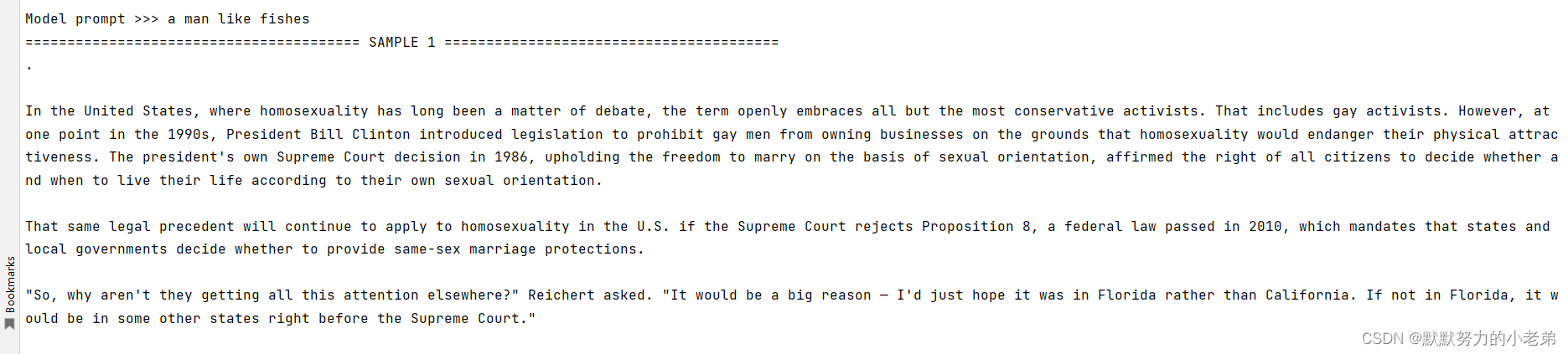

//效果不好,难道模型太小了? 我说fish 他说 同志/女同 的法律与预期不赋

//6个G…下载好了再看看效果

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!