中文医疗大模型的近况

2023-12-26 13:48:34

医疗大模型

- FROM BEGINNER TO EXPERT: MODELING MEDICAL KNOWLEDGE INTO GENERAL LLMS

- Taiyi: A Bilingual Fine-Tuned Large Language Model for Diverse Biomedical Tasks. 2023

- AlpaCare: Instruction-tuned Large Language Models for Medical Application.

- BianQue: Balancing the Questioning and Suggestion Ability of Health LLMs with Multi-turn Health Conversations Polished by ChatGPT

- Qilin-Med: Multi-stage Knowledge Injection Advanced Medical Large Language Model

- Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue

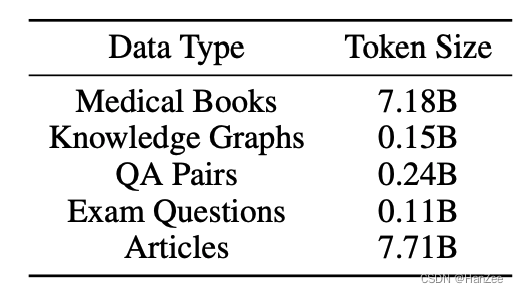

FROM BEGINNER TO EXPERT: MODELING MEDICAL KNOWLEDGE INTO GENERAL LLMS

未开源

提出了三阶段训练方法:

- 医疗领域Post- Training

- 通用QA 微调

- 通过C-play 增强下游场景任务。

第一阶段训练数据:

Taiyi: A Bilingual Fine-Tuned Large Language Model for Diverse Biomedical Tasks. 2023

提出了两阶段sft,差不多是大量的低质量多样性预料学习领域知识,医疗数据sft。

开源了数据集清单。

AlpaCare: Instruction-tuned Large Language Models for Medical Application.

提出了类似于self-instruct的医疗数据生成方法,并开源了52k sft data.通过Rouge-L去重。

BianQue: Balancing the Questioning and Suggestion Ability of Health LLMs with Multi-turn Health Conversations Polished by ChatGPT

主张多轮问询CoQ,通过好大夫开源的问答数据,清洗了一遍,然后用ChatGPT润色。

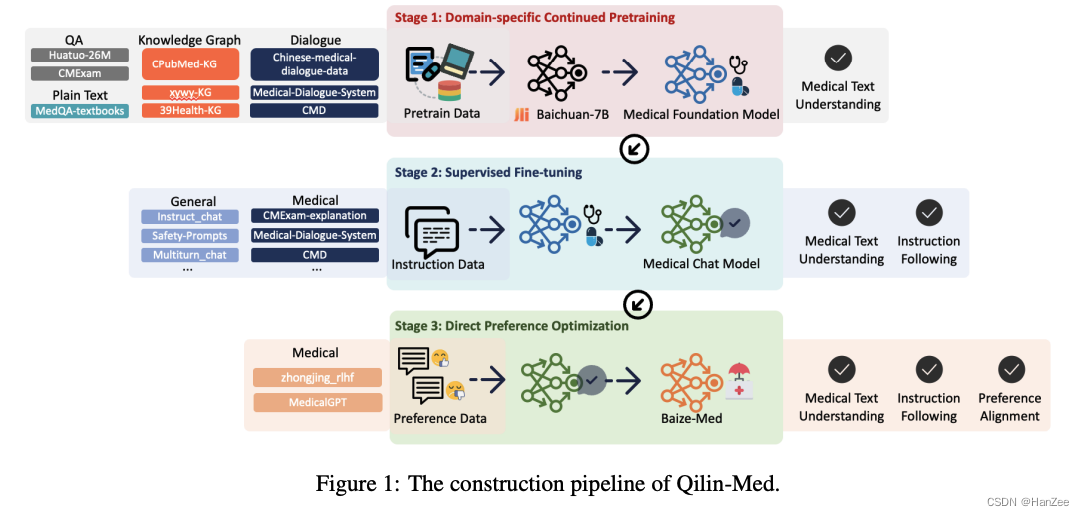

Qilin-Med: Multi-stage Knowledge Injection Advanced Medical Large Language Model

分为三阶段:CPT + SFT + DPO ,公开了使用的数据清单。

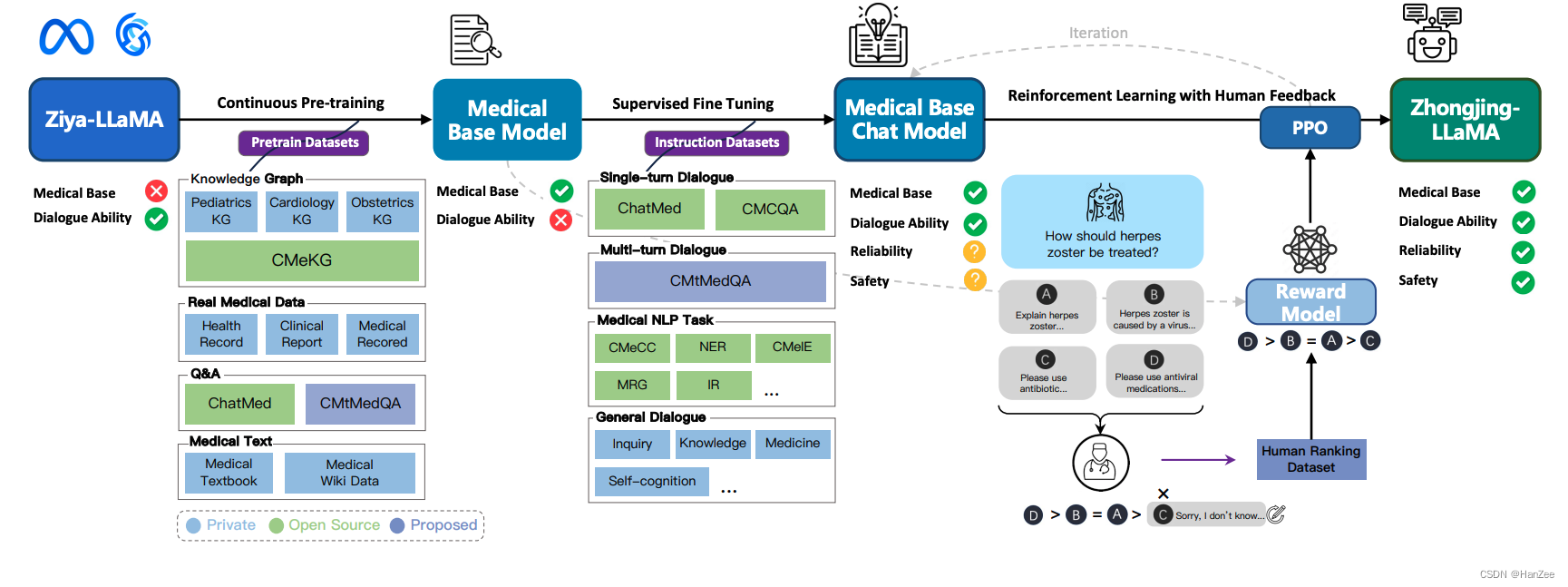

Zhongjing: Enhancing the Chinese Medical Capabilities of Large Language Model through Expert Feedback and Real-world Multi-turn Dialogue

开源了数据清单,跑通了CPT + SFT + PPO

文章来源:https://blog.csdn.net/qq_18555105/article/details/135204671

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!