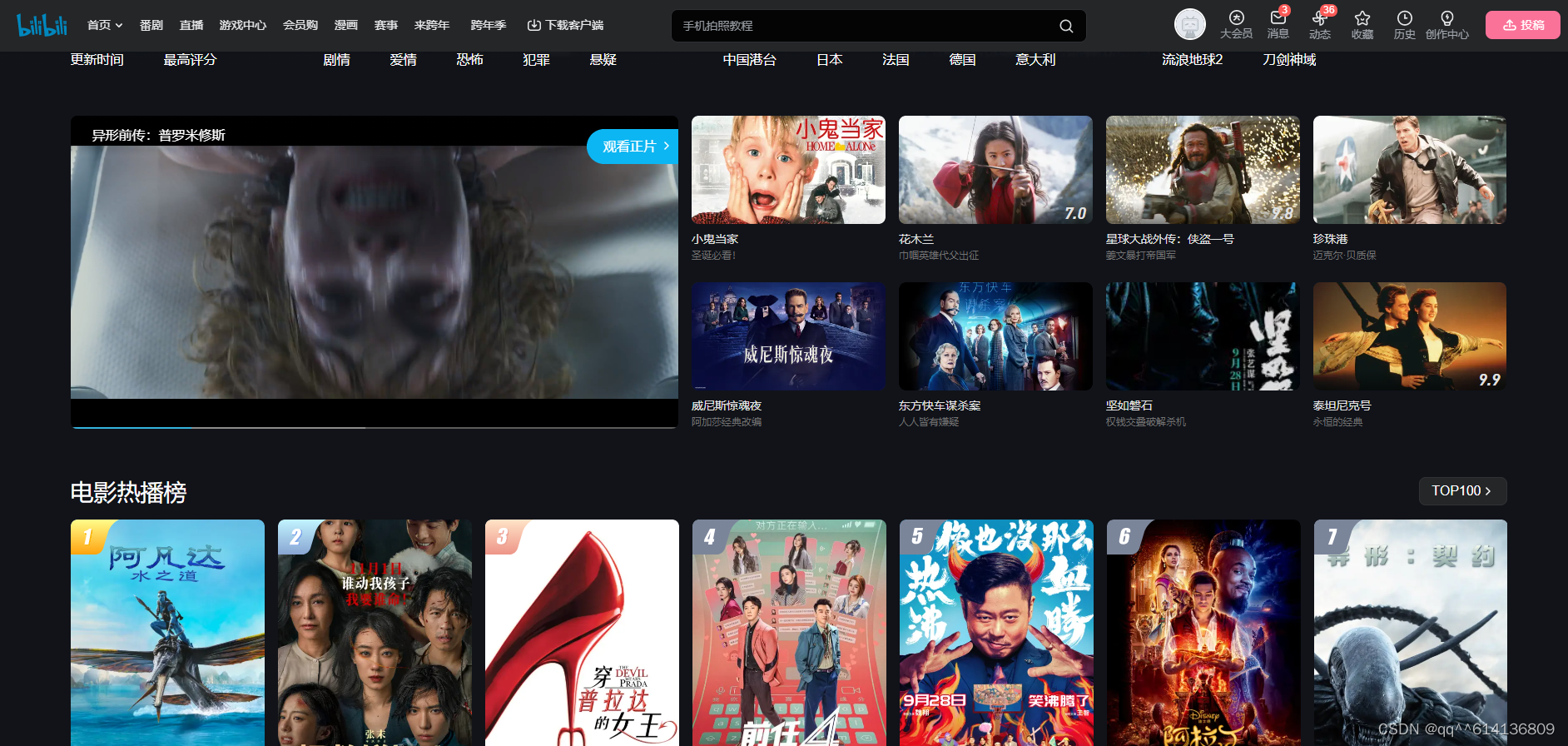

如何使用Python的requests库和BeautifulSoup库来爬取B站电影数据

2023-12-29 10:20:43

爬取更多电影信息:除了电影名称、链接和评分,您可以尝试爬取更多的电影信息,如导演、演员、简介、上映时间等。根据B站电影页面的HTML结构,使用BeautifulSoup库提取相应的信息。

分页爬取:B站电影页面通常是分页显示的,您可以使用循环和参数化URL来实现分页爬取。通过修改URL中的页码参数,循环发送请求并解析每一页的电影数据。

异步爬取:使用异步爬虫库(如aiohttp、asyncio等)来提高爬取效率,同时发送多个请求并异步处理响应。这样可以减少爬取时间,并且能够更好地处理B站页面的异步加载。

数据存储:将爬取到的电影数据保存到数据库或文件中,以便后续的数据分析或使用。您可以使用Python的数据库库(如MySQLdb、sqlite3等)或文件操作库(如csv、json等)来实现数据存储。

添加异常处理:在进行网络请求和解析时,可能会遇到各种异常情况,如网络连接错误、页面解析错误等。为了保证爬虫的稳定性和健壮性,可以添加适当的异常处理机制,如try-except语句,以捕获并处理异常情况。

设置请求头:为了模拟正常的浏览器行为,可以设置请求头信息,包括User-Agent、Referer等。这样可以避免被网站识别为爬虫并进行反爬虫处理。

使用Python的requests库和BeautifulSoup库来爬取B站电影数据的示例代码:

import requests

from bs4 import BeautifulSoup

http://www.jshk.com.cn/mb/reg.asp?kefu=xiaoding;//爬虫IP获取;

url = "https://www.bilibili.com/movie/"

response = requests.get(url)

html = response.text

soup = BeautifulSoup(html, "html.parser")

获取电影列表

movie_list = soup.find_all("li", class_="movie-serial-item")

for movie in movie_list:

# 获取电影名称

name = movie.find("a", class_="movie-card-wrap")["title"]

# 获取电影链接

link = movie.find("a", class_="movie-card-wrap")["href"]

# 获取电影评分

score = movie.find("div", class_="movie-card-score").text.strip()

print(name, link, score)

文章来源:https://blog.csdn.net/D0126_/article/details/135261310

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!

本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。 如若内容造成侵权/违法违规/事实不符,请联系我的编程经验分享网邮箱:veading@qq.com进行投诉反馈,一经查实,立即删除!